ガイドの概要

このガイドの目的は、Keycloakサーバーの初回起動の前に完了する必要があるいくつかの手順について説明することです。Keycloakをテストしたいだけの場合は、組み込みのローカル専用のデータベースでそのまま実行する方がよいでしょう。実際にプロダクション環境にデプロイしたい場合は、まずどのようにランタイム(スタンドアローン・モードまたはドメインモード)でサーバー設定を管理するか決定して、Keycloakの共有データベースを設定し、暗号化とHTTPSの設定を行い、最後にKeycloakをセットアップしてクラスター内で起動する必要があります。このガイドは、Keycloakサーバーをデプロイする前に、起動に先んじて定義と設定が必要なすべての手順を、ひとつひとつ説明していきます。

ただし、KeycloakはWildFlyアプリケーション・サーバーに基づいていて、Keycloakの設定はWildFlyの設定項目と密接に関わっています。そのためこのガイドでは、詳細な説明について、このチュートリアルとは別の外部ドキュメントを紹介することがあります。その点は留意ください。

ソフトウェアのインストール

Keycloakのインストールは、ダウンロードして解凍するだけです。この章では、配布物のディレクトリー構造とシステム要件について説明します。

インストールの前提条件

これらの前提条件は、Keycloak サーバーをインストールするために存在します。

-

Javaが実行可能なオペレーティング・システム

-

Java 8 JREまたはJava 11 JRE

-

zipまたはgzip、およびtar

-

RAM512M以上

-

ディスクスペース1G以上

-

PostgreSQL、MySQL、Oracleなどの共有外部データベース。Keycloakをクラスターで実行する場合は、外部共有データベースが必要です。詳細については、このガイドのデータベース設定のセクションを参照してください。

-

クラスターを構成する場合はマルチキャスト・ネットワークのサポート。Keycloakは マルチキャストなしでもクラスターを構成できますが、多くの設定変更が必要になります。詳しくは、このガイドのクラスタリングセクションを参照してください。

-

Linuxにおいては、セキュリティー・ポリシーにより

/dev/randomの使用が義務付けられている場合を除き、ランダムデータのソースとして/dev/urandomを使用することをお勧めします。エントロピー不足が原因でKeycloakが固まるのを防ぐことができます。Oracle JDK 8およびOpenJDK 8でこれを使用するには、 起動時のjava.security.egdシステム・プロパティーをfile:/dev/urandomに設定してください。

Keycloakサーバーのインストール

Keycloakサーバーには、ダウンロード可能な2つの配布物があります。

-

keycloak-15.1.1.[zip|tar.gz]このファイルは、サーバーのみの配布物です。Keycloakサーバーを実行するためのスクリプトとバイナリー以外は何も含まれていません。

-

keycloak-overlay-15.1.1.[zip|tar.gz]このファイルは、既存のWildFlyディストリビューションの上にKeycloakサーバーをインストールするために使用できるWildFlyアドオンです。 アプリケーションとKeycloakを同じサーバー・インスタンスで動作させたいというユーザーには対応していません。

-

Keycloakサーバーをインストールするには、お使いのOSの

unzipまたはgunzipとtarユーティリティーをkeycloak-15.1.1.[zip|tar.gz]ファイル上で実行します。 -

Keycloak Service Packをインストールするには、別のサーバー・インスタンスにインストールする必要があります。

-

あなたのWildFlyディストリビューションのルート・ディレクトリーに移動します。

-

keycloak-overlay-15.1.1.[zip|tar.gz]ファイルを解凍してください。 -

シェルでbinディレクトリーを開きます。

-

./jboss-cli.[sh|bat] --file=keycloak-install.cliを実行します。

-

重要なディレクトリ

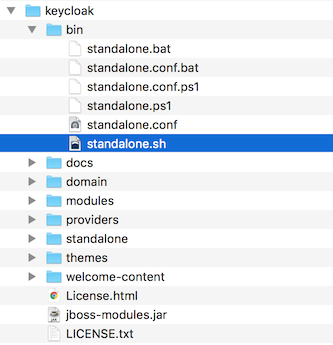

サーバー配布物の中で重要なディレクトリを以下に示します。

- bin/

-

サーバーの起動またはサーバー上でその他管理操作を行う、さまざまなスクリプトが含まれています。

- domain/

-

Keycloakをドメインモードで実行する場合の、設定ファイルとワーキング・ディレクトリーが含まれています。

- modules/

-

サーバー上で使用されるすべてのJavaライブラリーです。

- standalone/

-

Keycloakをスタンドアローン・モードで実行する場合の、設定ファイルとワーキング・ディレクトリーが含まれています。

- standalone/deployments/

-

Keycloakの拡張を作成する場合、ここに配置することができます。詳しくは、 Server Developer Guide を参照してください。

- themes/

-

このディレクトリーには、サーバーによって表示されるUI画面を表示するために使用されるすべてのHTML、スタイルシート、JavaScriptファイル、および画像が含まれます。ここでは、既存のテーマを変更したり、独自のテーマを作成したりすることができます。詳細については、 Server Developer Guide を参照してください。

動作モードの使い方

プロダクション環境にKeycloakを導入する前に、どのタイプの動作モードを使用するかを決める必要があります。

-

Keycloakをクラスター内で実行するか?

-

サーバーの設定を一元的に管理したいか?

動作モードの選択は、データベースの設定やキャッシングの設定、さらにはサーバーの起動方法にも影響します。

| KeycloakはWildFlyアプリケーション・サーバー上に構築されています。このガイドでは、基本的な特定のモードでのデプロイメントについて説明します。詳しくは、WildFly 23 Documentationを参照してください。 |

スタンドアローン・モードの使用

スタンドアローン動作モードは、サーバーに1つのKeycloakサーバー・インスタンスを起動する場合にのみ有効です。クラスター構成には使用できません。また、キャッシュは分散されておらずローカル専用です。スタンドアローン・モードは単一障害点となりえるので、プロダクション環境での使用はお勧めしません。スタンドアローン・モードのサーバーがダウンした場合、ユーザーはログインできなくなります。そのため、このモードはテストおよびKeycloakの機能を試す目的にのみ有効です。

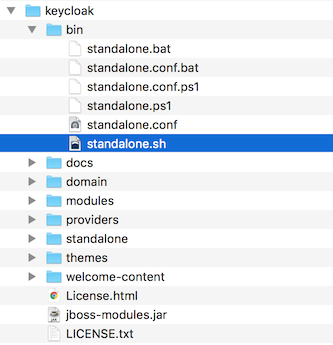

スタンドアローン・モードでの起動

スタンドアローン・モードでサーバーを実行する場合、使用するオペレーティング・システムに応じて、サーバーを起動するために必要な特定のスクリプトがあります。これらのスクリプトは、サーバー配布物の bin/ ディレクトリーにあります。

To boot the server:

$ .../bin/standalone.sh> ...\bin\standalone.batスタンドアローン・モード構成

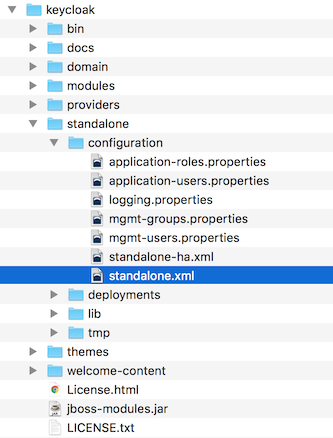

このガイドの大半は、Keycloakの基盤レベルの設定について説明します。このレベルの設定は、Keycloakが構築されたアプリケーション・サーバーに特化した設定ファイル内に定義されます。スタンドアローン動作モードでは、このファイルは …/standalone/configuration/standalone.xml にあります。また、このファイルはKeycloakのコンポーネントに特化した非基盤レベルの設定にも使用されます。

| サーバーの実行中にこのファイルに変更を加えても、反映されず、サーバーに上書きされる可能性があります。その場合は、代わりにWildFlyのwebコンソールまたはコマンドライン・スクリプトを使用します。詳しくは、WildFly 23 Documentationを参照してください。 |

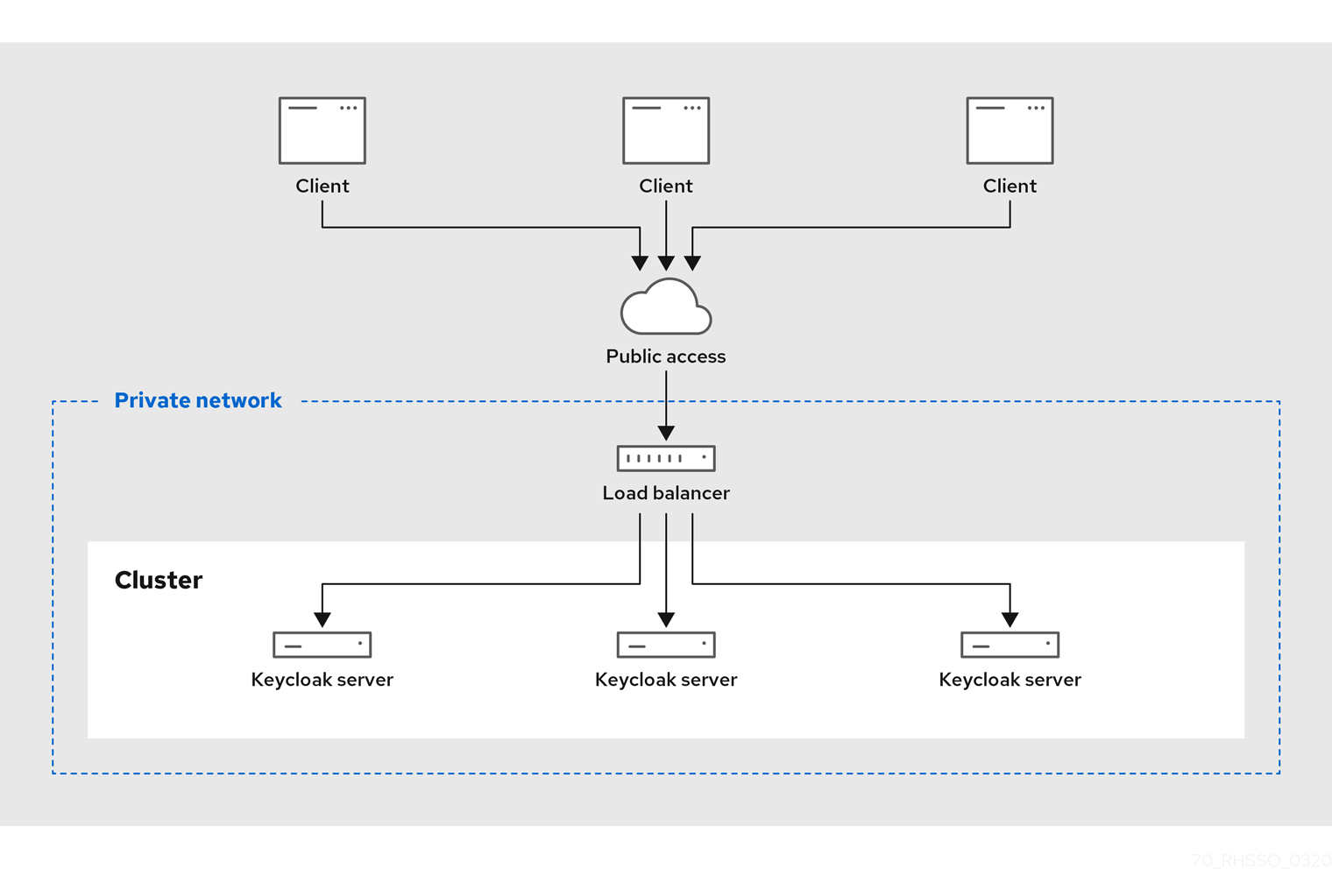

スタンドアローン・クラスター・モードの使用

スタンドアローン・クラスター動作モードは、クラスター内でKeycloakを実行するときに適用します。このモードでは、サーバー・インスタンスを実行する各マシンにKeycloakの配布物のコピーが保存されている必要があります。このモードは、最初は非常に簡単にデプロイできますが、後でかなり煩雑になる可能性があります。設定を変更するには、各マシンの配布物を修正します。大規模なクラスターの場合、時間がかかり、エラーも発生しやすくなります。

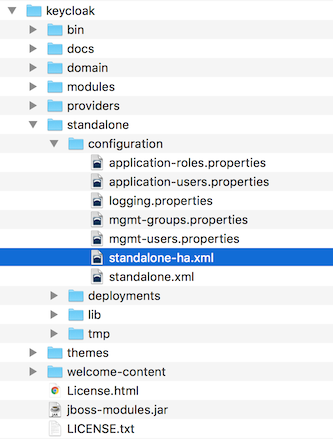

スタンドアローン・クラスター設定

この配布物には、クラスター内で実行するためのアプリケーション・サーバーの設定ファイルが含まれており、その大半は設定が済んでいます。ネットワーク、データベース、キャッシュ、およびディスカバリーのための基盤設定がすべて含まれています。このファイルは …/standalone/configuration/standalone-ha.xml にあります。しかし、この設定だけでは足りません。共有データベース接続を設定せずに、クラスター内でKeycloakを実行することはできません。また、クラスターのフロントに何らかのロードバランサーを配備する必要があります。このガイドのクラスタリングとデータベースのセクションでは、これらのことを説明します。

| サーバーの実行中にこのファイルに変更を加えても、反映されず、サーバーに上書きされる可能性があります。その場合は、代わりにWildFlyのwebコンソールまたはコマンドライン・スクリプトを使用します。詳しくは、WildFly 23 Documentationを参照してください。 |

スタンドアローン・クラスター・モードでの起動

Keycloakを起動するには、スタンドアローン・モードで実行したのと同じ起動スクリプトを使用します。スタンドアローン・モードとの違いは、HA設定ファイルを指し示す追加フラグを渡すという点になります。

To boot the server:

$ .../bin/standalone.sh --server-config=standalone-ha.xml> ...\bin\standalone.bat --server-config=standalone-ha.xmlドメイン・クラスター・モードの使用

ドメインモードとは、サーバーの設定を一元管理し、クラスター内の各サーバーに反映させる方法です。

標準モードでクラスターを実行すると、クラスターが大きくなり、煩雑化する可能性があります。設定を変更する必要があるたびに、クラスター内の各ノードでそれを実行します。一方、ドメインモードの場合は、設定を保存しパブリッシュするために一元管理する場所を提供することで、この問題を解決できます。セットアップにはかなり手間がかかりますが、最終的にはその工数は見合うことになります。この機能はKeycloakが構成されるWildFlyアプリケーション・サーバーに組み込まれています。

| このガイドでは、ドメインモードの初歩的なところを説明します。クラスター内でのドメインモードのセットアップ手順について、詳しくは、WildFly 23 Documentationを参照してください。 |

ドメインモードを実行する基本的なコンセプトは、以下のとおりです。

- ドメイン・コントローラー

-

ドメイン・コントローラーとは、クラスター内の各ノードの一般的な設定を保存、管理、パブリッシュする役割をもつ、プロセスのことです。また、クラスター内の各ノードが取得する設定を一元管理するデータベースでもあります。

- ホスト・コントローラー

-

ホスト・コントローラーの役割は、特定のマシン内のサーバー・インスタンスを管理することです。1つ以上のサーバー・インスタンスを実行できるよう、ホスト・コントローラーを設定することになります。また、ドメイン・コントローラーはクラスターを管理するために、各マシン内のホスト・コントローラーと連携します。実行プロセスを減らすために、ドメイン・コントローラーに、特定のマシン内のホスト・コントローラーとしての役割を担わせることもできます。

- ドメイン・プロファイル

-

ドメイン・プロファイルとは、サーバーを起動するために使用する、名前付きの設定セットです。ドメイン・コントローラーで、複数のドメイン・プロファイルを定義することができます。そして、さまざまなサーバーがこのドメイン・プロファイルを使うことになります。

- サーバーグループ

-

サーバーグループとは、サーバーの集合体です。ひとつの集合体として管理、設定されます。サーバーグループに、ドメイン・プロファイルを割り当てることができます。そして、そのドメイン・プロファイルはサーバーグループ内のサービスの設定として使用されます。

ドメインモードでは、マスターノード上でドメイン・コントローラーが起動されます。クラスターの設定は、ドメイン・コントローラー内にあります。次に、ホスト・コントローラーがクラスター内の各マシンで起動されます。各ホスト・コントローラーのデプロイ設定では、そのマシンで起動するKeycloakサーバー・インスタンスの数を指定します。ホスト・コントローラーが起動すると、指定された数のKeycloakサーバー・インスタンスが起動します。これらのサーバー・インスタンスは、ドメイン・コントローラーから設定を取得します。

| Microsoft Azureなどの一部の環境では、ドメインモードは適用されません。WildFlyのドキュメントを参照してください。 |

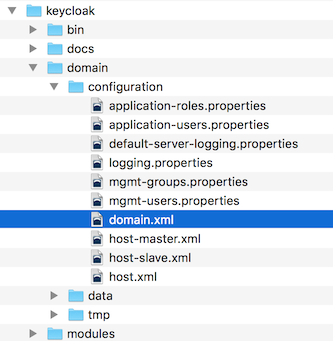

ドメイン設定

このガイドの各章では、データベース、HTTPネットワーク接続、キャッシュ、およびその他の基盤関連のさまざまな設定について説明します。これらを設定するために、スタンドアローン・モードでは standalone.xml ファイルを使用するのに対して、ドメインモードでは …/domain/configuration/domain.xml を使用します。Keycloakサーバーのドメイン・プロファイルとサーバーグループは、以下で定義されます。

| ドメイン・コントローラーの実行中にこのファイルに変更を加えても、変更されず、サーバーに上書きされる可能性があります。その場合は、代わりにWildFlyのwebコンソールまたはコマンドライン・スクリプトを使用します。詳しくは、WildFly 23 Documentationを参照してください。 |

この domain.xml ファイルの特徴を確認していきましょう。 auth-server-standalone と auth-server-clustered の profile のXMLブロックでは、どのような設定にするかの大半を定義します。そして、ネットワーク接続、キャッシュ、データベース接続などを設定します。

<profiles>

<profile name="auth-server-standalone">

...

</profile>

<profile name="auth-server-clustered">

...

</profile>auth-server-standalone プロファイルは、非クラスター構成のセットアップ用です。一方 auth-server-clustered プロファイルは、クラスター構成のセットアップ用です。

スクロールダウンしていくと、定義済みの socket-binding-groups が表示されます。

<socket-binding-groups>

<socket-binding-group name="standard-sockets" default-interface="public">

...

</socket-binding-group>

<socket-binding-group name="ha-sockets" default-interface="public">

...

</socket-binding-group>

<!-- load-balancer-socketsはプロダクション環境では取り除かれ、高度なソフトウェアまたはハードウェアに取り換えられます -->

<socket-binding-group name="load-balancer-sockets" default-interface="public">

...

</socket-binding-group>

</socket-binding-groups>この設定では、各Keycloakサーバー・インスタンスによって開かれる、さまざまなコネクターのデフォルトポートマッピングを定義します。 ${…} を含む値はコマンドラインの -D スイッチで上書きできる値です。すなわち、以下のように上書きできます。

$ domain.sh -Djboss.http.port=80

Keycloakのサーバーグループの定義は、 server-groups のXMLブロックにあります。ホスト・コントローラーがインスタンスを起動する場合、この定義により、 default で使用されているドメイン・プロファイル、およびJava VMのデフォルト起動引数が指定されます。また、 socket-binding-group はサーバーグループにバインドされます。

<server-groups>

<!-- load-balancer-groupはプロダクション環境では取り除かれ、高度なソフトウェアまたはハードウェアに取り換えられます -->

<server-group name="load-balancer-group" profile="load-balancer">

<jvm name="default">

<heap size="64m" max-size="512m"/>

</jvm>

<socket-binding-group ref="load-balancer-sockets"/>

</server-group>

<server-group name="auth-server-group" profile="auth-server-clustered">

<jvm name="default">

<heap size="64m" max-size="512m"/>

</jvm>

<socket-binding-group ref="ha-sockets"/>

</server-group>

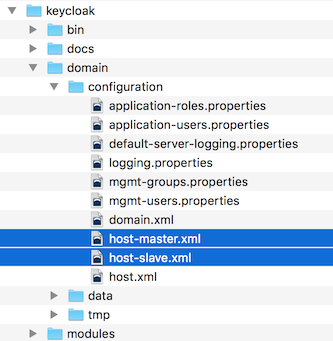

</server-groups>ホスト・コントローラー設定

Keycloakには、 …/domain/configuration/ ディレクトリーにある、 host-master.xml と host-slave.xml の2つのホスト・コントローラー設定ファイルが付属しています。 host-master.xml はドメイン・コントローラー、ロードバランサー、および1つのKeycloakサーバー・インスタンスを起動するように設定されています。一方、 host-slave.xml はドメイン・コントローラーと通信し、1つのKeycloakサーバー・インスタンスを起動するように設定されています。

| ロードバランサーは必須サービスではありません。これは、開発マシン上でクラスタリングを簡単にテストできるようにするものです。プロダクション環境で使用可能ですが、使いたい別のハードウェアまたはソフトウェア・ベースのロードバランサーがあるなら、置き換えるかどうかを選択できます。 |

ロードバランサー・サーバー・インスタンスを無効にするには、 host-master.xml を編集し、 "load-balancer" エントリーをコメントアウトまたは削除します。

<servers>

<!-- 次の行を削除またはコメントアウト -->

<server name="load-balancer" group="loadbalancer-group"/>

...

</servers>このファイルのもう一つの興味深い点は、認証サーバー・インスタンスの宣言です。これには、 port-offset という設定があります。 domain.xml の socket-binding-group やサーバーグループで定義されたネットワークポートには、 port-offset の値が追加されます。このサンプルドメインの設定では、ロードバランサー・サーバーが開くポートが、起動している認証サーバー・インスタンスと衝突しないように、このようにしています。

<servers>

...

<server name="server-one" group="auth-server-group" auto-start="true">

<socket-bindings port-offset="150"/>

</server>

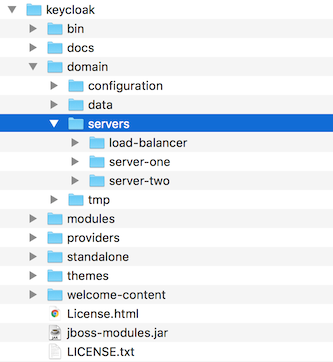

</servers>サーバー・インスタンス・ワーキング・ディレクトリー

ホスト・ファイルに定義されている各Keycloakサーバー・インスタンスにより、 …/domain/servers/{SERVER NAME} の下に作業ディレクトリーが作成されます。そこに追加の設定を保存でき、サーバー・インスタンスが必要とする、または作成する一時ファイル、ログファイル、データファイルも保存することができます。これらのサーバー・ディレクトリーごとの構造は、他のWildFlyブートサーバーと同じようなものになります。

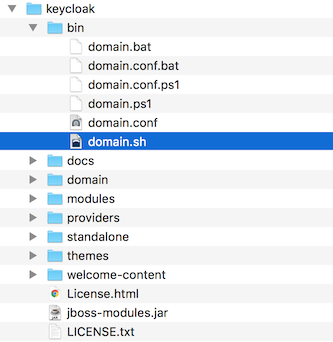

ドメイン・クラスター・モードでの起動

ドメインモードでサーバーを実行する場合、オペレーティング・システム固有の起動スクリプトを実行する必要があります。これらのスクリプトは、サーバー配布物の bin/ ディレクトリーにあります。

To boot the server:

$ .../bin/domain.sh --host-config=host-master.xml> ...\bin\domain.bat --host-config=host-master.xml起動スクリプトを実行する場合、 --host-config スイッチ経由で、使用するホスト制御設定ファイルを渡す必要があります。

クラスター化されたドメインのサンプルを使ったテスト

サンプルの domain.xml 設定を使用してクラスタリングをテストできます。このサンプルドメインは、1台のマシンで実行され、以下を起動します。

-

ドメイン・コントローラー

-

HTTPロードバランサー

-

2つのKeycloakサーバー・インスタンス

-

2つのホスト・コントローラーを起動するために、

domain.shスクリプトを2回実行します。1つ目はマスター・ホスト・コントローラーで、ドメイン・コントローラー、HTTPロードバランサー、1つのKeycloak認証サーバー・インスタンスを起動します。2つ目はスレーブ・ホスト・コントローラーで、認証サーバーのインスタンスのみを起動します。

-

スレーブ・ホスト・コントローラーがドメイン・コントローラーと安全に通信できるように設定します。以下の手順を実行してください。

これらの手順を省略すると、スレーブホストはドメイン・コントローラーから集中管理された設定を取得できません。

-

マスターとスレーブの間で共有されるサーバー管理者のユーザーとシークレットを作成し、安全な接続を設定します。

`…/bin/add-user.sh`スクリプトを実行してください。

-

スクリプトで追加するユーザーの種類を尋ねられたら、

Management Userを選択します。この選択により、 …/domain/configuration/host-slave.xml ファイルにカット&ペーストするシークレットが生成されます。

アプリケーション・サーバー管理者の追加$ add-user.sh What type of user do you wish to add? a) Management User (mgmt-users.properties) b) Application User (application-users.properties) (a): a Enter the details of the new user to add. Using realm 'ManagementRealm' as discovered from the existing property files. Username : admin Password recommendations are listed below. To modify these restrictions edit the add-user.properties configuration file. - The password should not be one of the following restricted values {root, admin, administrator} - The password should contain at least 8 characters, 1 alphabetic character(s), 1 digit(s), 1 non-alphanumeric symbol(s) - The password should be different from the username Password : Re-enter Password : What groups do you want this user to belong to? (Please enter a comma separated list, or leave blank for none)[ ]: About to add user 'admin' for realm 'ManagementRealm' Is this correct yes/no? yes Added user 'admin' to file '/.../standalone/configuration/mgmt-users.properties' Added user 'admin' to file '/.../domain/configuration/mgmt-users.properties' Added user 'admin' with groups to file '/.../standalone/configuration/mgmt-groups.properties' Added user 'admin' with groups to file '/.../domain/configuration/mgmt-groups.properties' Is this new user going to be used for one AS process to connect to another AS process? e.g. for a slave host controller connecting to the master or for a Remoting connection for server to server EJB calls. yes/no? yes To represent the user add the following to the server-identities definition <secret value="bWdtdDEyMyE=" />add-user.sh スクリプトは、ユーザーを Keycloak サーバーに追加するのではなく、基盤となるJBoss Enterprise Application Platformに追加します。このスクリプトで使用および生成されるクレデンシャルは、デモ目的でのみ使用されます。お使いのシステムで生成されたものを使用してください。

-

-

…/domain/configuration/host-slave.xml ファイルにシークレットの値をカット・アンド・ペーストすると、以下のようになります。

<management> <security-realms> <security-realm name="ManagementRealm"> <server-identities> <secret value="bWdtdDEyMyE="/> </server-identities> -

作成したユーザーの username も …/domain/configuration/host-slave.xml ファイルに追加します。

<remote security-realm="ManagementRealm" username="admin"> -

ブートスクリプトを2回実行して、1台の開発マシンで2つのノードクラスターをシミュレートします。

マスターの起動$ domain.sh --host-config=host-master.xmlスレーブの起動$ domain.sh --host-config=host-slave.xml -

ブラウザーを開いてhttp://localhost:8080/authにアクセスし、試してみてください。

クロスサイト・レプリケーション・モードの使用

|

cross-site replication modeは、 テクノロジー・プレビュー であり、完全にはサポートされていません。 |

クロスサイト・レプリケーション・モードを使用して、複数のデータセンターにまたがるクラスターでKeycloakを実行します。一般的には、異なる地域にあるデータセンターのサイトを使用します。このモードを使用すると、各データセンターはKeycloakサーバーの独自のクラスターを持つことになります。

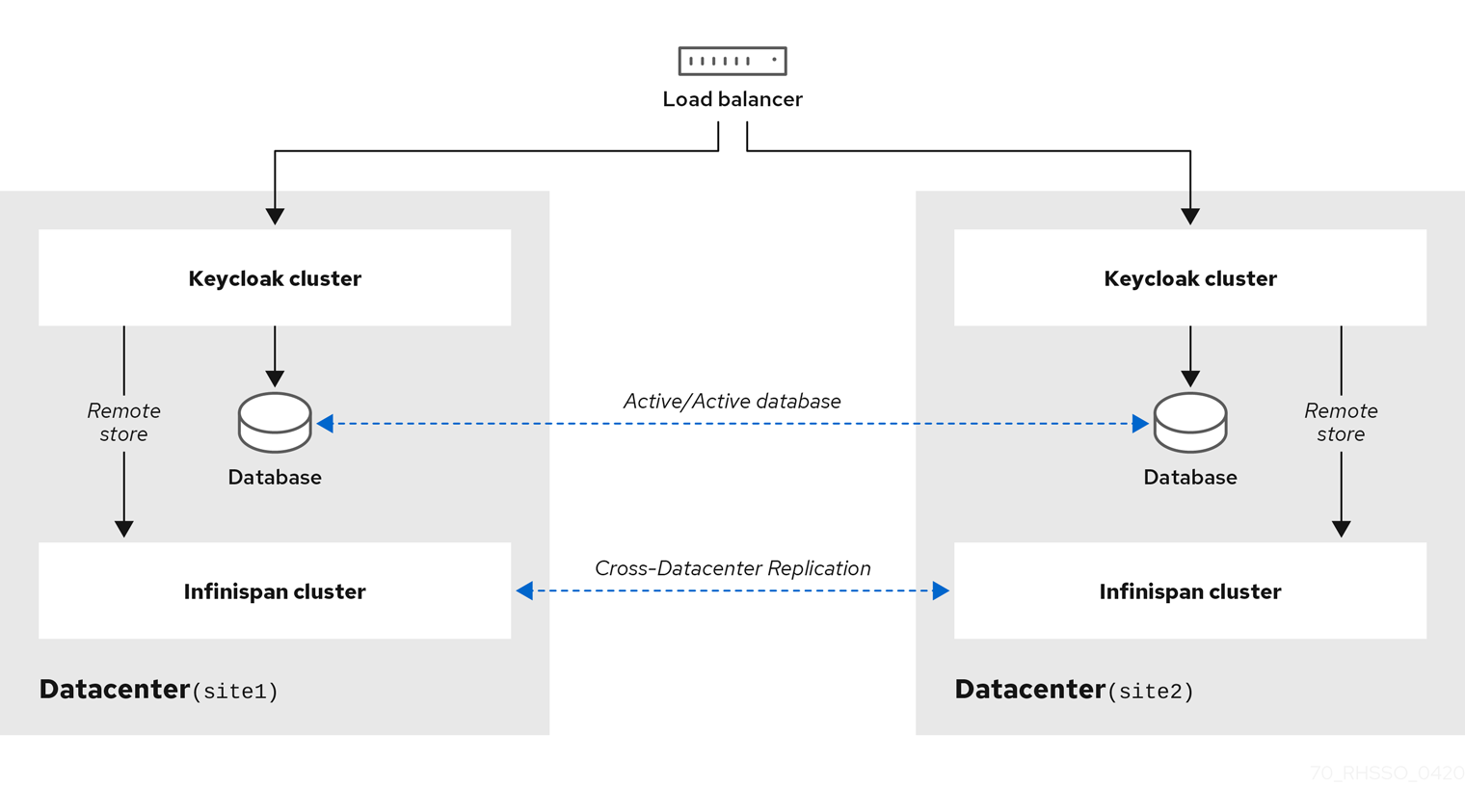

このドキュメントでは、以下のアーキテクチャー図の例を参照して、シンプルなクロスサイト・レプリケーションのユースケースを説明します。

前提条件

これは高度なトピックのため、最初に以下を読み、背景にある重要な知識を身につけておくことをお勧めします。

-

Keycloakによるクラスタリング クロスデータセンター・レプリケーションを設定する場合、より独立したKeycloakクラスターを使用するため、クラスターの仕組みや、ロード・バランシング、共有データベース、マルチキャストなどの基本的な概念と要件を理解する必要があります。

-

Infinispan Cross-Site Replication は、地理的に離れた場所にあるクラスター間でデータをレプリケーションします。

技術的な詳細

このセクションでは、Keycloakクロスサイト・レプリケーションの仕組みについて概念と詳細について説明します。

Keycloakはステートフルなアプリケーションです。データソースとして以下のものを使用します。

-

データベースは、ユーザー情報などの永続的なデータを保持するために使用されます。

-

Infinispanキャッシュは、永続化データをデータベースからキャッシュし、短期間で頻繁に変化するメタデータ(ユーザー・セッションなど)を節約するためにも使用されます。Infinispanは通常、データベースよりもはるかに高速ですが、Infinispanを使用して保存されたデータは永続的ではなく、クラスターを再起動後も維持できるとは限りません。

このアーキテクチャーの例では、 site1 と site2 と呼ばれる2つのデータセンターがあります。クロスサイト・レプリケーションでは、両方のデータソースが確実に動作し、 site2 のKeycloakサーバーによって保存されたデータを site1 のKeycloakサーバーが最終的に読み取ることができるようにする必要があります。

環境に基づいて、次の選択肢から決める必要があります。

-

信頼性 - 通常はアクティブ/アクティブモードで使用されます。

site1で記述されたデータはsite2ですぐに表示される必要があります。 -

パフォーマンス - 通常はアクティブ/パッシブモードで使用されます。

site1で記述されたデータはすぐにsite2で表示される必要はありません。状況によって、site2でデータが表示されないこともあります。

詳細は、モードを参照してください。

リクエスト処理

エンドユーザーのブラウザーは、HTTPリクエストをフロント・エンド・ロードバランサーに送信します。このロードバランサーは、通常mod_cluster、NGINX、HA Proxy、またはその他のソフトウェアかハードウェア・ロードバランサーを使用するHTTPDまたはWildFlyです。

ロードバランサーは、基になるKeycloakインスタンスに、受け取ったHTTPリクエストを転送します。このインスタンスは、複数のデータセンターに分散させることができます。ロードバランサーは通常、スティッキー・セッションをサポートしています。つまり、ロードバランサーは、同じデータセンターの同じKeycloakインスタンスに、同じユーザーのすべてのHTTPリクエストを常に転送することができます。

クライアント・アプリケーションからロードバランサーに送られたHTTPリクエストは バックチャネル・リクエスト と呼ばれます。これらはエンドユーザーのブラウザーからは見えないので、ユーザーとロードバランサー間でスティッキー・セッションの一部になることはできません。バックチャネル・リクエストの場合、ロードバランサーは、HTTPリクエストを任意のデータセンター内のいずれかのKeycloakインスタンスに転送することができます。これは、いくつかのOpenID ConnectといくつかのSAMLフローがユーザーとアプリケーションの両方から複数のHTTPリクエストを必要とするため、難しい問題です。関連するすべてのリクエストを同じデータセンター内の同じKeycloakインスタンスに送信するのにスティッキー・セッションに完全に依存することはできないため、代わりに、データセンター間で一部のデータをレプリケートする必要があります。それにより、データは特定のフロー中の後続のHTTPリクエストによって表示されます。

モード

要件に応じて、クロスサイト・レプリケーションには2つの基本的な動作モードがあります。

-

アクティブ/パッシブ - ユーザーとクライアント・アプリケーションは、単一のデータセンター内のKeycloakノードにのみリクエストを送信します。第2のデータセンターは、データを保存するための

バックアップとしてのみ使用されます。メインのデータセンターに障害が発生した場合、通常は第2のデータセンターからデータを復旧します。 -

アクティブ/アクティブ - ユーザーとクライアント・アプリケーションは、両方のデータセンターのKeycloakノードにリクエストを送信します。つまり、両方のサイトですぐにデータを表示し、 両方のサイトのKeycloakサーバーからデータをすぐに使用できるようにする必要があります。これは、Keycloakサーバーが

site1に何かしらのデータを書き込む場合に特に当てはまります。また、site1への書き込みが完了した直後に、site2のKeycloakサーバーがデータをすぐに読み取ることができるようにする必要があります。

アクティブ/パッシブモードは、パフォーマンスに優れています。いずれかのモードでキャッシュを設定する方法の詳細については、 SYNCまたはASYNCバックアップ を参照してください。

データベース

Keycloakは、リレーショナル・データベース・マネジメント・システム(RDBMS)を使用して、レルム、クライアント、ユーザーなどのメタデータを保持します。詳細については、サーバーインストールガイドのこの章を参照してください。クロスサイト・レプリケーションのセットアップでは、両方のデータセンターが同じデータベースと通信するか、すべてのデータセンターに独自のデータベース・ノードがあり、両方のデータベース・ノードがデータセンター間で同期レプリケートされると想定しています。どちらの場合でも、 site1 のKeycloakサーバーがデータを保持してトランザクションをコミットすると、 site2 の後続のDBトランザクションによって、それらのデータがすぐに表示される必要があります。

DBのセットアップの詳細については、Keycloakの範囲外ですが、MariaDBやOracleなどのRDBMSベンダーの多くは、レプリケートされたデータベースと同期レプリケーションを提供しています。これらのベンダーを使用して、Keycloakをテストしています。

-

Oracle Database 19c RAC

-

Galera 3.12 cluster for MariaDB server version 10.1.19-MariaDB

Infinispanキャッシュ

このセクションでは、Infinispanキャッシュの概要を説明していきます。キャッシュの設定の詳細は以下のとおりです。

Keycloakには、認証セッションの概念があります。 authenticationSessions と呼ばれる別のInfinispanキャッシュがあり、特定のユーザーの認証時にデータを保存するのに使用されます。このキャッシュからのリクエストには通常、ブラウザーとKeycloakサーバーのみが関与し、アプリケーションは関与しません。ここでは、アクティブ/アクティブモードであっても、スティッキー・セッションに依存することができ、 authenticationSessions キャッシュ・コンテンツをデータセンター間でレプリケートする必要はありません。

アクション・トークンの概念もあります。アクション・トークンは、通常、ユーザーが電子メールでアクションを非同期で確認する必要があるシナリオで使用されます。たとえば、 forget password フローの間に、 actionTokens Infinispanキャッシュは、どのアクション・トークンがすでに使用されているかなどの関連するアクション・トークンに関するメタデータを追跡するために使用されるため、2度目は再利用できません。これは通常、データセンター間でレプリケートする必要があります。

KeycloakはInfinispanを使用して永続化データをキャッシュし、データベースへの不要なリクエストを多く回避します。キャッシュによりパフォーマンスは改善されますが、さらなる問題が加わります。一部のKeycloakサーバーがデータを更新した場合、すべてのデータセンターの他のすべてのKeycloakサーバーはそのことに気づく必要があるため、それらのキャッシュから特定のデータを無効にします。Keycloakは、 realms 、 users 、および authorization と呼ばれるローカルInfinispanキャッシュを使用して、永続化データをキャッシュします。

すべてのデータセンターでレプリケートされる、別のキャッシュ work を使用します。workキャッシュ自体は実際のデータをキャッシュしません。クラスターノードとデータセンター間で無効化メッセージを送信する場合にのみ使用されます。つまり、データ(ユーザー john のようなデータ)が更新されると、Keycloakノードは、同じデータセンター内の他のすべてのクラスターノード、および他のすべてのデータセンターに無効化メッセージを送信します。すべてのノードは、無効通知を受信した後、ローカル・キャッシュから適切なデータを無効にします。

sessions 、 clientSessions 、 offlineSessions 、および offlineClientSessions と呼ばれるInfinispanキャッシュがあり、それらのすべては通常、データセンター間でレプリケートされる必要があります。これらのキャッシュは、ユーザー・セッションに関するデータを保存するために使用され、ユーザーのブラウザー・セッションの長さに対して有効です。キャッシュは、エンドユーザーとアプリケーションからのHTTPリクエストを処理する必要があります。前述のとおり、このインスタンスではスティッキー・セッションを信頼性をもって使用することはできませんが、後続のHTTPリクエストが最新のデータを確認できるようにする必要があります。このため、データは通常、データセンター間でレプリケートされます。

最後に、 loginFailures キャッシュは、ユーザー john が不正なパスワードを入力した回数など、ログイン失敗に関するデータを追跡するために使用されます。詳細は、こちらを参照してください。このキャッシュをデータセンター間でレプリケートするかどうかは、管理者次第です。正確なログイン失敗の回数を取得するには、レプリケーションが必要です。一方、このデータをレプリケートしないことで、パフォーマンスをよくできます。したがって、パフォーマンスがログイン失敗の正確な回数よりも重要な場合は、レプリケーションを避けるという手もあります。

キャッシュの設定方法の詳細については、Infinispanキャッシュ設定のチューニングを参照してください。

コミュニケーションの詳細

Keycloakは、Infinispanキャッシュの分割されたクラスターを複数使用します。各Keycloakノードは、同じデータセンター内の他のKeycloakノードと共にクラスター内にありますが、異なるデータセンターのKeycloakノードはそのクラスター内にありません。Keycloakノードは、異なるデータセンターのKeycloakノードと直接通信できません。Keycloakノードは、データセンター間の通信に外部JDG(実際にはInfinispanサーバー)を使用します。これは、 Infinispan HotRodプロトコル を使用して行われます。

Keycloak側のInfinispanキャッシュは、データがリモート・キャッシュに保存されていることを確認するために、 remoteStore を使用して設定する必要があります。JDGサーバー間に分割されたInfinispanクラスターがあるので、 site1 のJDG1に保存されていたデータは site2 のJDG2にレプリケートされます。

受信Infinispanサーバーは、Hot Rodプロトコルの機能であるクライアント・リスナーを介して、クラスター内のKeycloakサーバーに通知します。次に、 site2 のKeycloakノードがInfinispanキャッシュを更新し、特定のユーザー・セッションが site2 のKeycloakノードにも表示されます。

詳細は、アーキテクチャー図の例を参照してください。

Infinispan 11.0.8でクロスサイトを設定する

以下の手順で、Infinispan 11.0.8のクロスサイト・レプリケーションの基本的な設定を行います。

Infinispan 11.0.8のこの例には、 site1 と site2 の2つのデータセンターが含まれます。各データセンターは、1つのInfinispanサーバーと2つのKeycloakサーバーで構成されています。合計すると、2つのInfinispanサーバーと4つのKeycloakサーバーになります。

-

Site1は、Infinispanサーバーのserver1と2つのKeycloakサーバーのnode11およびnode12で構成されています。 -

Site2は、Infinispanサーバーのserver2と2つのKeycloakサーバーのnode21およびnode22で構成されています。 -

Infinispanサーバーである

server1とserver2は、 Infinispan のドキュメント で記載されているのと同様の方法で、RELAY2プロトコルとbackupベースのInfinispanキャッシュを介して相互に接続されています。 -

Keycloakサーバーである

node11とnode12は、お互いにクラスターを形成しますが、site2内のサーバーとは直接通信はしません。それらはHot Rodプロトコル (リモート・キャッシュ)を使用して、Infinispanサーバーserver1と通信します。詳細については、コミュニケーションの詳細を参照してください。 -

同じ説明が

node21とnode22にも当てはまります。それらはお互いにクラスター化し、Hot Rodプロトコルを使用して、server2サーバーとのみ通信します。

この設定の例では、4つのKeycloakサーバーすべてが同じデータベースと通信することを前提としています。プロダクション環境では、データベースで説明されているとおり、データセンター間で別々の同期レプリケートされたデータベースを使用することをお勧めします。

Infinispanサーバーのセットアップ

クロスサイト・レプリケーションの場合、KeycloakのデータをバックアップできるリモートInfinispanクラスターを作成することから始めます。

-

Infinispanサーバー11.0.8をダウンロードしてインストールします。

|

Infinispanサーバー11.0.8にはJava 11が必要です。 |

-

Infinispanからのクライアント接続を認証するユーザーを作成します。次に例を示します。

$ bin/cli.sh user create myuser -p "qwer1234!"Keycloakにリモートキャッシュを作成するときに、HotRodクライアントの設定でこれらのクレデンシャルを指定します。

-

InfinispanとKeycloakの間の接続を保護するために、SSLキーストアとトラストストアを作成します。次に例を示します。

-

キーストアを作成して、InfinispanクラスターにSSLのIDを提供します

keytool -genkey -alias server -keyalg RSA -keystore server.jks -keysize 2048 -

キーストアからSSL証明書をエクスポートします。

keytool -exportcert -keystore server.jks -alias server -file server.crt -

KeycloakがInfinispanのSSLのIDを確認するために使用できるトラストストアに、SSL証明書をインポートします。

keytool -importcert -keystore truststore.jks -alias server -file server.crt -

server.crtを削除します。rm server.crt

-

Infinispanクラスターの設定

データセンター間でKeycloakデータを複製するようにInfinispanクラスターを設定します。

-

Infinispanサーバーをインストールしてセットアップします。

-

編集のために

infinispan.xmlを開きます。デフォルトでは、Infinispanサーバーはクラスター・トランスポートやセキュリティー機構などの静的設定に

server/conf/infinispan.xmlを使用します。 -

クラスター検出プロトコルとしてTCPPINGを使用するスタックを作成します。

<stack name="global-cluster" extends="tcp"> <!-- Remove MPING protocol from the stack and add TCPPING --> <TCPPING initial_hosts="server1[7800],server2[7800]" (1) stack.combine="REPLACE" stack.position="MPING"/> </stack>1 server1とserver2のホスト名を一覧表示します。 -

Infinispanのクラスター・トランスポートを設定して、クロスサイト・レプリケーションを実行します。

-

RELAY2プロトコルをJGroupsスタックに追加します。

<jgroups> <stack name="xsite" extends="udp"> (1) <relay.RELAY2 site="site1" (2) max_site_masters="1000"/> (3) <remote-sites default-stack="global-cluster"> (4) <remote-site name="site1"/> <remote-site name="site2"/> </remote-sites> </stack> </jgroups>1 デフォルトのUDPクラスター・トランスポートを拡張する xsiteという名前のスタックを作成します。2 RELAY2プロトコルを追加し、設定しているクラスターに site1という名前を付けます。サイト名は、各Infinispanクラスターに固有である必要があります。3 クラスターのリレーノードの数として1000を設定します。Infinispanクラスター内のノードの最大数以上の値を設定する必要があります。 4 InfinispanデータでキャッシュをバックアップするすべてのInfinispanクラスターに名前を付け、クラスター間転送にデフォルトのTCPスタックを使用します。 -

スタックを使用するようにInfinispanクラスター・トランスポートを設定します。

<cache-container name="default" statistics="true"> <transport cluster="${infinispan.cluster.name:cluster}" stack="xsite"/> (1) </cache-container>1 クラスターに xsiteスタックを使用します。

-

-

サーバー・セキュリティー・レルムでキーストアをSSLのIDとして設定します。

<server-identities> <ssl> <keystore path="server.jks" (1) relative-to="infinispan.server.config.path" keystore-password="password" (2) alias="server" /> (3) </ssl> </server-identities>1 SSLのIDを含むキーストアのパスを指定します。 2 キーストアにアクセスするためのパスワードを指定します。 3 キーストア内の証明書のエイリアスに名前を付けます。 -

HotRodエンドポイントの認証機構を設定します。

<endpoints socket-binding="default"> <hotrod-connector name="hotrod"> <authentication> <sasl mechanisms="SCRAM-SHA-512" (1) server-name="infinispan" /> (2) </authentication> </hotrod-connector> <rest-connector name="rest"/> </endpoints>1 Hot RodのエンドポイントのSASL認証メカニズムを設定します。SCRAM-SHA-512は、Hot RodのデフォルトのSASLメカニズムです。ただし、GSSAPIなど、環境に応じて適切なものを使用できます。 2 Infinispanサーバーがクライアントに提示する名前を定義します。この名前は、Keycloakを設定するときにHotRodクライアントの設定で指定します。 -

キャッシュ・テンプレートを作成します。

Infinispanクラスター内の各ノードの infinispan.xmlにキャッシュ・テンプレートを追加します。<cache-container ... > <replicated-cache-configuration name="sessions-cfg" (1) mode="SYNC"> (2) <locking acquire-timeout="0" /> (3) <backups> <backup site="site2" strategy="SYNC" /> (4) </backups> </replicated-cache-configuration> </cache-container>1 sessions-cfgという名前のキャッシュ・テンプレートを作成します。2 クラスター全体でデータを同期的に複製するキャッシュを定義します。 3 ロック獲得のタイムアウトを無効にします。 4 設定しているInfinispanクラスターのバックアップ・サイトに名前を付けます。 -

Infinispanのserver1を起動します。

./server.sh -c infinispan.xml -b PUBLIC_IP_ADDRESS -k PUBLIC_IP_ADDRESS -Djgroups.mcast_addr=228.6.7.10 -

Infinispanのserver2を起動します。

./server.sh -c infinispan.xml -b PUBLIC_IP_ADDRESS -k PUBLIC_IP_ADDRESS -Djgroups.mcast_addr=228.6.7.11 -

Infinispanサーバーログをチェックして、クラスターがクロスサイト・ビューを形成していることを確認します。

INFO [org.infinispan.XSITE] (jgroups-5,${server.hostname}) ISPN000439: Received new x-site view: [site1] INFO [org.infinispan.XSITE] (jgroups-7,${server.hostname}) ISPN000439: Received new x-site view: [site1, site2]

Infinispanキャッシュの生成

Keycloakが必要とするInfinispanキャッシュを生成します。

infinispan.xml にキャッシュを追加するのではなく、実行時にInfinispanクラスターにキャッシュを作成することをお勧めします。この戦略により、キャッシュがクラスター全体で自動的に同期され、永続的に保存されます。

次の手順では、Infinispanコマンドライン・インターフェイス(CLI)を使用して、必要なすべてのキャッシュを1つのバッチコマンドで作成します。

-

Infinispanクラスターを設定します。

-

たとえば、次にようにキャッシュを含むバッチファイルを作成します。

cat > /tmp/caches.batch<<EOF echo "creating caches..." create cache work --template=sessions-cfg create cache sessions --template=sessions-cfg create cache clientSessions --template=sessions-cfg create cache offlineSessions --template=sessions-cfg create cache offlineClientSessions --template=sessions-cfg create cache actionTokens --template=sessions-cfg create cache loginFailures --template=sessions-cfg echo "verifying caches" ls caches EOF -

CLIを使用してキャッシュを作成します。

$ bin/cli.sh -c https://server1:11222 --trustall -f /tmp/caches.batch引数 --trustallの代わりに、引数-tでトラストストアを指定し、-s引数でトラストストア・パスワードを指定できます。 -

他のサイトにキャッシュを作成します。

Keycloakでのリモート・キャッシュ・ストアの設定

リモートのInfinispanクラスターをセットアップした後、KeycloakでInfinispanサブシステムを設定して、リモートストアを介してそれらのクラスターにデータを外部化します。

-

クロスサイト設定用にリモートInfinispanクラスターをセットアップします。

-

InfinispanServerのIDを持つSSL証明書を含むトラストストアを作成します。

-

トラストストアをKeycloakの配備に追加します。

-

Infinispanクラスターを指すソケット・バインディングを作成します。

<outbound-socket-binding name="remote-cache"> (1) <remote-destination host="${remote.cache.host:server_hostname}" (2) port="${remote.cache.port:11222}"/> (3) </outbound-socket-binding>1 ソケット・バインディングに remote-cacheという名前を付けます。2 Infinispanクラスターに対して1つ以上のホスト名を指定します。 3 HotRodエンドポイントがリッスンする 11222のポートを定義します。 -

org.keycloak.keycloak-model-infinispanモジュールをInfinispanサブシステムのkeycloakキャッシュ・コンテナーに追加します。<subsystem xmlns="urn:jboss:domain:infinispan:12.0"> <cache-container name="keycloak" modules="org.keycloak.keycloak-model-infinispan"/> -

Infinispanサブシステムの

workキャッシュを更新して、次の設定にします。<replicated-cache name="work"> (1) <remote-store cache="work" (2) remote-servers="remote-cache" (3) passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="infinispan.client.hotrod.auth_username">myuser</property> <property name="infinispan.client.hotrod.auth_password">qwer1234!</property> <property name="infinispan.client.hotrod.auth_realm">default</property> <property name="infinispan.client.hotrod.auth_server_name">infinispan</property> <property name="infinispan.client.hotrod.sasl_mechanism">SCRAM-SHA-512</property> <property name="infinispan.client.hotrod.trust_store_file_name">/path/to/truststore.jks</property> <property name="infinispan.client.hotrod.trust_store_type">JKS</property> <property name="infinispan.client.hotrod.trust_store_password">password</property> </remote-store> </replicated-cache>1 Infinispanの設定でキャッシュに名前を付けます。 2 リモートInfinispanクラスター上の対応するキャッシュに名前を付けます。 3 remote-cacheソケット・バインディングを指定します。上記のキャッシュ設定には、Infinispanキャッシュの推奨設定が含まれています。Hot Rodクライアント設定プロパティーは、Infinispanユーザー・クレデンシャルとSSLのキーストアおよびトラストストアの詳細を指定します。

次の文書を参照してください。 Infinispan documentation 各プロパティーの説明については

-

次の各キャッシュに対する分散キャッシュをInfinispanサブシステムに追加します。

-

sessions

-

clientSessions

-

offlineSessions

-

offlineClientSessions

-

actionTokens

-

loginFailures

たとえば、次の設定で

sessionsという名前のキャッシュを追加します。<distributed-cache name="sessions" (1) owners="1"> (2) <remote-store cache="sessions" (3) remote-servers="remote-cache" (4) passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="infinispan.client.hotrod.auth_username">myuser</property> <property name="infinispan.client.hotrod.auth_password">qwer1234!</property> <property name="infinispan.client.hotrod.auth_realm">default</property> <property name="infinispan.client.hotrod.auth_server_name">infinispan</property> <property name="infinispan.client.hotrod.sasl_mechanism">SCRAM-SHA-512</property> <property name="infinispan.client.hotrod.trust_store_file_name">/path/to/truststore.jks</property> <property name="infinispan.client.hotrod.trust_store_type">JKS</property> <property name="infinispan.client.hotrod.trust_store_password">password</property> </remote-store> </distributed-cache>1 Infinispanの設定でキャッシュに名前を付けます。 2 Infinispanクラスター全体で各キャッシュ・エントリーのレプリカを1つ設定します。 3 リモートInfinispanクラスター上の対応するキャッシュに名前を付けます。 4 remote-cacheソケット・バインディングを指定します。

-

-

NODE11を後述するNODE12、NODE21、NODE22という3つのディレクトリーにコピーしてください。 -

次のように、

NODE11を起動してください。cd NODE11/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node11 -Djboss.site.name=site1 \ -Djboss.default.multicast.address=234.56.78.1 -Dremote.cache.host=server1 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSログに次の警告メッセージが表示された場合は、無視しても問題ありません。

WARN [org.infinispan.CONFIG] (MSC service thread 1-5) ISPN000292: Unrecognized attribute 'infinispan.client.hotrod.auth_password'. Please check your configuration. Ignoring! WARN [org.infinispan.CONFIG] (MSC service thread 1-5) ISPN000292: Unrecognized attribute 'infinispan.client.hotrod.auth_username'. Please check your configuration. Ignoring! -

次のように、

NODE12を起動してください。cd NODE12/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node12 -Djboss.site.name=site1 \ -Djboss.default.multicast.address=234.56.78.1 -Dremote.cache.host=server1 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSクラスター・ノードを接続する必要があります。このようなものは、NODE11とNODE12のどちらのログにも残っていなければなりません。

Received new cluster view for channel keycloak: [node11|1] (2) [node11, node12]ログにあるチャネル名とは異なっている可能性があります。 -

次のように、

NODE21を起動してください。cd NODE21/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node21 -Djboss.site.name=site2 \ -Djboss.default.multicast.address=234.56.78.2 -Dremote.cache.host=server2 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSNODE11とNODE12を使用してクラスターに接続するのではなく、別のクラスターに接続する必要があります。Received new cluster view for channel keycloak: [node21|0] (1) [node21] -

次のように、

NODE22を起動してください。cd NODE22/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node22 -Djboss.site.name=site2 \ -Djboss.default.multicast.address=234.56.78.2 -Dremote.cache.host=server2 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSNODE21をクラスター化する必要があります。Received new cluster view for channel keycloak: [node21|1] (2) [node21, node22]ログにあるチャネル名とは異なっている可能性があります。 -

次のように、テストを行ってください。

-

http://node11:8080/auth/に移動し、最初の管理者ユーザーを作成します。 -

http://node11:8080/auth/adminに移動し、管理者として管理コンソールにログインします。 -

2つ目のブラウザーを開き、

http://node12:8080/auth/adminまたはhttp://node21:8080/auth/adminもしくはhttp://node22:8080/auth/adminのいずれかのノードに移動します。ログイン後、4つのすべてのサーバー上の特定のユーザー、クライアントまたはレルムのSessionsタブで同じセッションを表示できます。 -

Keycloakの管理コンソールで変更を行った後、ユーザーやレルムの変更などを行います。管理者コンソールでユーザーやレルムの変更を行った後、その変更は4つのノードのいずれかですぐに表示されるはずです。キャッシュはすべての場所で適切に無効化されているはずです。

-

必要に応じてserver.logsを確認してください。ログインまたはログアウト後、以下のようなメッセージがすべての

NODEXY/standalone/log/server.logノードに表示される必要があります。2017-08-25 17:35:17,737 DEBUG [org.keycloak.models.sessions.infinispan.remotestore.RemoteCacheSessionListener] (Client-Listener-sessions-30012a77422542f5) Received event from remote store. Event 'CLIENT_CACHE_ENTRY_REMOVED', key '193489e7-e2bc-4069-afe8-f1dfa73084ea', skip 'false'

-

Infinispan 9.4.19でのクロスサイト・レプリケーションの設定

Infinispan 9.4.19のこの例には、 site1 と site2 の2つのデータセンターが含まれます。各データセンターは、1つのInfinispanサーバーと2つのKeycloakサーバーで構成されています。合計すると、2つのInfinispanサーバーと4つのKeycloakサーバーになります。

-

Site1は、Infinispanサーバーのserver1と2つのKeycloakサーバーのnode11およびnode12で構成されています。 -

Site2は、Infinispanサーバーのserver2と2つのKeycloakサーバーのnode21およびnode22で構成されています。 -

Infinispanサーバーである

server1とserver2は、 Infinispan のドキュメント で記載されているのと同様の方法で、RELAY2プロトコルとbackupベースのInfinispanキャッシュを介して相互に接続されています。 -

Keycloakサーバーである

node11とnode12は、お互いにクラスターを形成しますが、site2内のサーバーとは直接通信はしません。それらはHot Rodプロトコル (リモート・キャッシュ)を使用して、Infinispanサーバーserver1と通信します。詳細については、コミュニケーションの詳細を参照してください。 -

同じ説明が

node21とnode22にも当てはまります。それらはお互いにクラスター化し、Hot Rodプロトコルを使用して、server2サーバーとのみ通信します。

この設定の例では、4つのKeycloakサーバーすべてが同じデータベースと通信することを前提としています。プロダクション環境では、データベースで説明されているとおり、データセンター間で別々の同期レプリケートされたデータベースを使用することをお勧めします。

Infinispanサーバーのセットアップ

Infinispanサーバーの設定は、以下の手順に沿って行います。

-

Infinispan 9.4.19サーバーをダウンロードし、選択したディレクトリーに解凍します。このロケーションは、

SERVER1_HOMEとして後ほど参照することになります。 -

JGroupsサブシステムの設定で、

SERVER1_HOME/server/conf/infinispan-xsite.xml内にあるこれらを変更します。-

xsiteチャネルを追加して、channels要素の下にあるtcpスタックを使用します。<channels default="cluster"> <channel name="cluster"/> <channel name="xsite" stack="tcp"/> </channels> -

relay要素をudpスタックの最後尾に追加します。自身のサイトはsite1で、バックアップする他のサイトはsite2というように設定します。<stack name="udp"> ... <relay site="site1"> <remote-site name="site2" channel="xsite"/> <property name="relay_multicasts">false</property> </relay> </stack> -

MPINGの代わりに、tcpスタックを設定してTCPPINGプロトコルを使用します。MPING要素を削除してTCPPINGに置き換えます。initial_hosts要素は、ホストserver1とserver2を指します。<stack name="tcp"> <transport type="TCP" socket-binding="jgroups-tcp"/> <protocol type="TCPPING"> <property name="initial_hosts">server1[7600],server2[7600]</property> <property name="ergonomics">false</property> </protocol> <protocol type="MERGE3"/> ... </stack>これは、単にすばやく実行するための設定例です。プロダクション環境では、JGroups RELAY2にtcpスタックを使用する必要はなく、他のどのスタックを設定しても構いません。たとえば、データセンター間のネットワークがマルチキャストをサポートできる場合は、デフォルトのudpスタックを使用することができます。InfinispanとKeycloakクラスターがお互いを見つけることはできないという点だけは確認してください。同じように、TCPPINGを検出プロトコルとして使用する必要はありません。また、TCPPINGは静的な性質であるため、使用することはないでしょう。最後に、サイト名も設定することができます。この設定のより詳細な内容については、Keycloakドキュメントの範囲外になります。詳細については、InfinispanのドキュメントおよびJGroupsのドキュメントを参照してください。

-

-

SERVER1_HOME/standalone/configuration/clustered.xmlのclusteredという名前のcache-containerの下に次の設定を追加します。<cache-container name="clustered" default-cache="default" statistics="true"> ... <replicated-cache-configuration name="sessions-cfg" mode="SYNC" start="EAGER" batching="false"> <locking acquire-timeout="0" /> <backups> <backup site="site2" failure-policy="FAIL" strategy="SYNC" enabled="true"> <take-offline min-wait="60000" after-failures="3" /> </backup> </backups> </replicated-cache-configuration> <replicated-cache name="work" configuration="sessions-cfg"/> <replicated-cache name="sessions" configuration="sessions-cfg"/> <replicated-cache name="clientSessions" configuration="sessions-cfg"/> <replicated-cache name="offlineSessions" configuration="sessions-cfg"/> <replicated-cache name="offlineClientSessions" configuration="sessions-cfg"/> <replicated-cache name="actionTokens" configuration="sessions-cfg"/> <replicated-cache name="loginFailures" configuration="sessions-cfg"/> </cache-container>replicated-cache-configuration内の設定オプションについての詳細は、Infinispanキャッシュ設定のチューニングで説明しています。これには、これらのオプションのいくつかを調整するための情報が含まれています。以前のバージョンとは異なり、Infinispanサーバーの replicated-cache-configurationはtransaction要素なしで設定する必要があります。詳細はトラブルシューティングを参照してください。 -

一部のInfinispanサーバーリリースでは、ネットワーク経由で保護されたキャッシュにアクセスする前に認可が必要です。

推奨されたInfinispan 9.4.19サーバーを使用している場合は、何も問題はありません。この手順は無視しても構いません(無視すべきです)。認可に関連する問題は、他のバージョンのInfinispanサーバーにのみ存在する可能性があります。 Keycloakはスクリプトを含む

___script_cacheキャッシュへの更新が必要です。このキャッシュにアクセスする際にエラーが発生した場合、下記のようにclustered.xml設定で認可を設定する必要があります。-

<management>のセクションの中で、次のようにセキュリティー・レルムを追加します。<management> <security-realms> ... <security-realm name="AllowScriptManager"> <authentication> <users> <user username="___script_manager"> <password>not-so-secret-password</password> </user> </users> </authentication> </security-realm> </security-realms> -

サーバー・コア・サブシステムで、以下のように

<security>を追加します。<subsystem xmlns="urn:infinispan:server:core:8.4"> <cache-container name="clustered" default-cache="default" statistics="true"> <security> <authorization> <identity-role-mapper/> <role name="___script_manager" permissions="ALL"/> </authorization> </security> ... -

エンドポイント・サブシステムで、Hot Rodコネクターに認証設定を追加します。

<subsystem xmlns="urn:infinispan:server:endpoint:8.1"> <hotrod-connector cache-container="clustered" socket-binding="hotrod"> ... <authentication security-realm="AllowScriptManager"> <sasl mechanisms="DIGEST-MD5" qop="auth" server-name="keycloak-jdg-server"> <policy> <no-anonymous value="false" /> </policy> </sasl> </authentication>

-

-

2つ目のロケーションにサーバーをコピーします。これは、

SERVER2_HOMEとして後ほど参照することになります。 -

SERVER2_HOME/standalone/configuration/clustered.xmlでは、site1をsite2に置き換えると、JGroupsサブシステム内のrelayの設定とcache-subsystem内のbackupsの設定の両方において、逆の動作をします。次に例を示します。-

relay要素は、以下のように表示されます。<relay site="site2"> <remote-site name="site1" channel="xsite"/> <property name="relay_multicasts">false</property> </relay> -

backups要素は、以下のように表示されます。<backups> <backup site="site1" .... ...以下の PUBLIC_IP_ADDRESS には、サーバーがバインドするために使用できるIPアドレスまたはホスト名を指します。すべてのInfinispanサーバーとKeycloakサーバーは異なるアドレスを使用する必要があることに注意してください。すべてのサーバーが同じ管理インターフェースを使用する必要があるため、すべてのサーバーが同じホストで実行されているセットアップ例では、オプション -Djboss.bind.address.management=PUBLIC_IP_ADDRESSを追加する必要がある場合があります。ただし、サーバーへのリモートアクセスを回避するために、このオプションは通常、プロダクション環境では外してください。詳細については、 WildFly 23 Documentation を参照してください。

-

-

server1サーバーを起動します。cd SERVER1_HOME/bin ./standalone.sh -c clustered.xml -Djava.net.preferIPv4Stack=true \ -Djboss.default.multicast.address=234.56.78.99 \ -Djboss.node.name=server1 -b PUBLIC_IP_ADDRESS -

server2サーバーを起動します。異なるマルチキャスト・アドレスがあるため、server1とserver2サーバーは互いに直接クラスター化されません。むしろ、それらはRELAY2プロトコルを介して接続されており、TCP JGroupsスタックはそれらの間の通信に使用されます。起動コマンドは次のようになります。cd SERVER2_HOME/bin ./standalone.sh -c clustered.xml -Djava.net.preferIPv4Stack=true \ -Djboss.default.multicast.address=234.56.78.100 \ -Djboss.node.name=server2 -b PUBLIC_IP_ADDRESS -

この時点でチャネルが動作していることを検証するには、JConsoleを使用し、実行中の

SERVER1またはSERVER2サーバーに接続する必要があります。MBeanjgroups:type=protocol,cluster="cluster",protocol=RELAY2およびprintRoutesオペレーションを使用すると、以下のような出力が表示されます。site1 --> _server1:site1 site2 --> _server2:site2MBean

jgroups:type=protocol,cluster="cluster",protocol=GMSを使用すると、属性メンバーには単一のメンバーしか含まれていないということがわかります。-

SERVER1では、以下のように表示されます。(1) server1 -

SERVER2では、以下のように表示されます。(1) server2プロダクション環境では、すべてのデータセンターにさらに多くのInfinispanサーバーを持つことができます。同じデータセンター内のInfinispanサーバーが同じマルチキャスト・アドレスを使用していること(つまり、起動中に同じ jboss.default.multicast.addressを使用していること)を確認するだけです。そうすると、GMSプロトコルビューのjconsoleに、現在のクラスターのメンバーがすべて表示されます。

-

Keycloakサーバーのセットアップ

-

Keycloakサーバー配布物を選択した場所に解凍します。これは

NODE11として後ほど参照することになります。 -

KeycloakDSデータソースの共有データベースを設定します。テストを目的とする場合は、MySQLまたはMariaDBの使用をお勧めします。詳細はデータベースを参照してください。

プロダクション環境では、すべてのデータセンターにおいて別々のデータベース・サーバーを用意する必要があり、両方のデータベース・サーバーを互いに同期してレプリケートする必要があります。設定例では、単一のデータベースを使用し、4つのKeycloakサーバーすべてに接続します。

-

NODE11/standalone/configuration/standalone-ha.xmlを以下のように編集してください。-

site属性をJGroups UDPプロトコルに追加します。<stack name="udp"> <transport type="UDP" socket-binding="jgroups-udp" site="${jboss.site.name}"/> -

workキャッシュの下にremote-storeを追加します。<replicated-cache name="work"> <remote-store cache="work" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </replicated-cache> -

sessionキャッシュの下にremote-storeを追加します。<distributed-cache name="sessions" owners="1"> <remote-store cache="sessions" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> -

offlineSessions、clientSessions、offlineClientSessions、loginFailures、actionTokensキャッシュでも同じことをします(sessionsキャッシュとの唯一の違いは、cacheプロパティー値が異なることです)。<distributed-cache name="offlineSessions" owners="1"> <remote-store cache="offlineSessions" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> <distributed-cache name="clientSessions" owners="1"> <remote-store cache="clientSessions" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> <distributed-cache name="offlineClientSessions" owners="1"> <remote-store cache="offlineClientSessions" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> <distributed-cache name="loginFailures" owners="1"> <remote-store cache="loginFailures" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="false" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> <distributed-cache name="actionTokens" owners="2"> <object-memory size="-1"/> <expiration max-idle="-1" interval="300000"/> <remote-store cache="actionTokens" remote-servers="remote-cache" passivation="false" fetch-state="false" purge="false" preload="true" shared="true"> <property name="rawValues">true</property> <property name="marshaller">org.keycloak.cluster.infinispan.KeycloakHotRodMarshallerFactory</property> <property name="protocolVersion">2.9</property> </remote-store> </distributed-cache> -

リモートストアのアウトバウンド・ソケット・バインディングを

socket-binding-group要素の設定に追加します。<outbound-socket-binding name="remote-cache"> <remote-destination host="${remote.cache.host:localhost}" port="${remote.cache.port:11222}"/> </outbound-socket-binding> -

分散キャッシュ設定の

authenticationSessionsと他のキャッシュは変更されません。 -

remoteStoreSecurityEnabledプロパティーをfalse(または上記のようにInfinispanサーバーのセキュリティを有効にした場合はtrue)の値で、 次のようにkeycloak-serverサブシステムのconnectionsInfinispanSPIに追加することをお勧めします<spi name="connectionsInfinispan"> ... <provider ...> <properties> ... <property name="remoteStoreSecurityEnabled" value="false"/> </properties> ... -

オプションで、

loggingサブシステムの下でDEBUGログを有効にします。<logger category="org.keycloak.cluster.infinispan"> <level name="DEBUG"/> </logger> <logger category="org.keycloak.connections.infinispan"> <level name="DEBUG"/> </logger> <logger category="org.keycloak.models.cache.infinispan"> <level name="DEBUG"/> </logger> <logger category="org.keycloak.models.sessions.infinispan"> <level name="DEBUG"/> </logger>

-

-

NODE11を後述するNODE12、NODE21、NODE22という3つのディレクトリーにコピーしてください。 -

次のように、

NODE11を起動してください。cd NODE11/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node11 -Djboss.site.name=site1 \ -Djboss.default.multicast.address=234.56.78.1 -Dremote.cache.host=server1 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESS -

次のように、

NODE12を起動してください。cd NODE12/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node12 -Djboss.site.name=site1 \ -Djboss.default.multicast.address=234.56.78.1 -Dremote.cache.host=server1 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSクラスター・ノードを接続する必要があります。このようなものは、NODE11とNODE12のどちらのログにも残っていなければなりません。

Received new cluster view for channel keycloak: [node11|1] (2) [node11, node12]ログにあるチャネル名とは異なっている可能性があります。 -

次のように、

NODE21を起動してください。cd NODE21/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node21 -Djboss.site.name=site2 \ -Djboss.default.multicast.address=234.56.78.2 -Dremote.cache.host=server2 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSNODE11とNODE12を使用してクラスターに接続するのではなく、クラスターを分離する必要があります。Received new cluster view for channel keycloak: [node21|0] (1) [node21] -

次のように、

NODE22を起動してください。cd NODE22/bin ./standalone.sh -c standalone-ha.xml -Djboss.node.name=node22 -Djboss.site.name=site2 \ -Djboss.default.multicast.address=234.56.78.2 -Dremote.cache.host=server2 \ -Djava.net.preferIPv4Stack=true -b PUBLIC_IP_ADDRESSNODE21をクラスター化する必要があります。Received new cluster view for channel keycloak: [node21|1] (2) [node21, node22]ログにあるチャネル名とは異なっている可能性があります。 -

次のように、テストを行ってください。

-

http://node11:8080/auth/に移動し、最初の管理者ユーザーを作成します。 -

http://node11:8080/auth/adminに移動し、管理者として管理コンソールにログインします。 -

2つ目のブラウザーを開き、

http://node12:8080/auth/adminまたはhttp://node21:8080/auth/adminもしくはhttp://node22:8080/auth/adminのいずれかのノードに移動します。ログイン後、4つのすべてのサーバー上の特定のユーザー、クライアントまたはレルムのSessionsタブで同じセッションを表示できます。 -

Keycloakの管理コンソールで変更(たとえば、ユーザーやレルムの更新など)を加えた後、その変更は、すぐに4つのノードのいずれかで表示され、キャッシュがどこでも適切に無効化される必要があります。

-

必要に応じてserver.logsを確認してください。ログインまたはログアウト後、以下のようなメッセージがすべての

NODEXY/standalone/log/server.logノードに表示される必要があります。2017-08-25 17:35:17,737 DEBUG [org.keycloak.models.sessions.infinispan.remotestore.RemoteCacheSessionListener] (Client-Listener-sessions-30012a77422542f5) Received event from remote store. Event 'CLIENT_CACHE_ENTRY_REMOVED', key '193489e7-e2bc-4069-afe8-f1dfa73084ea', skip 'false'

-

クロスサイト・デプロイメントの管理

このセクションでは、クロスサイト・レプリケーションに関連するヒントやオプションをご紹介します。

-

Keycloakサーバーをデータセンター内で実行する場合、

KeycloakDSデータソース内で参照されたデータベースがすでに実行され、そのデータセンター内で使用可能である必要があります。また、 Infinispanキャッシュのremote-store要素から参照されるoutbound-socket-bindingによって参照されたInfinispanサーバーがすでに実行されてることが必要です。そうしないと、Keycloakサーバーは起動に失敗します。 -

データベース・フェイルオーバーと高い信頼性をサポートする必要がある場合、すべてのデータセンターでより多くのデータベース・ノードを持たせます。データベース側での設定方法とKeycloak側の

KeycloakDSデータソースで必要な設定方法の詳細については、JDBCドライバーのドキュメントを参照してください。 -

すべてのデータセンターで、より多くのInfinispanサーバーをクラスター内で実行することができます。これは、フェイルオーバーとフォールト・トレランスを強化する場合に便利です。InfinispanサーバーとKeycloakサーバー間の通信で使用されるHot Rodプロトコルには、InfinispanサーバーがInfinispanクラスターの変更について、Keycloakサーバーに新しいトポロジーを自動的に送信する機能を備えています。したがって、Keycloak側のリモートストアは、どのInfinispanサーバーに接続できるのかが分かります。詳細については、InfinispanとWildFlyドキュメントを参照してください。

-

どんな サイトのKeycloakサーバーも起動する前に、すべてのサイトでマスターInfinispanサーバーを実行することを強くお勧めします。この例では、すべてのKeycloakサーバーの前に、

server1とserver2の両方を最初に起動します。Keycloakサーバーをそれでも実行する必要があり、バックアップ・サイトがオフラインである場合は、サイトをオフラインおよびオンラインにするでの説明のとおり、サイトのInfinispanサーバー上のバックアップ・サイトを手動でオフラインに切り替えることをお勧めします。使用できない状態のサイトをオフラインに手動で切り替えることができない場合、初回起動に失敗するか、起動時にいくつか例外が発生する可能性があります。これは、失敗した操作の設定数によってバックアップ・サイトが自動的にオフラインになるまでです。

サイトをオフラインおよびオンラインにする

たとえば、以下のようなシナリオを想定します。

-

サイト

site1から見たサイトsite2は、完全にオフラインです。これは、site2のすべてのInfinispanサーバーがオフである、 または 、site1とsite2の間のネットワークが切断されていることを意味します。 -

サイト

site1でKeycloakサーバーとInfinispanサーバーserver1を実行します。 -

いずれかのユーザーが

site1のKeycloakサーバーにログインします。 -

site1のKeycloakサーバーは、site2のserver2サーバーにデータをバックアップすることを想定し、server1サーバー上のリモート・キャッシュにセッションを書き込もうとします。詳細については、コミュニケーションの詳細を参照してください。 -

server2サーバーがオフラインであるか、server1から到達できない状態なので、server1からserver2へのバックアップは失敗します。 -

例外は

server1のログにスローされます。デフォルトのFAILバックアップ失敗ポリシーが設定されているため、その失敗はserver1サーバーからKeycloakサーバーにも伝播されます。バックアップ・ポリシーの詳細については、バックアップ失敗ポリシーを参照してください。 -

このエラーはKeycloak側でも発生し、ユーザーはログインを完了できない可能性もあります。

使用している環境に応じて、サイト間のネットワークが利用できないか、一時的に壊れている(スプリット・ブレイン)可能性があります。これが起こった場合、 site1 のInfinispanサーバーは、 site2 のInfinispanサーバーが利用できないことに気付き、 server2 サイトのサーバーへアクセスしようとするのを止めるため、バックアップの失敗は発生しません。これは サイトをオフラインにする と呼ばれています。

サイトをオフラインにするには2つの方法があります。

管理者による手作業 - 管理者は jconsole または他のツールを使用して、いくつかのJMX操作を実行することで、手動で特定のサイトをオフラインにすることができます。これは、特に停止が計画されている場合に役立ちます。 jconsole またはCLIを使用すると、 server1 サーバーに接続し、 site2 をオフラインにすることができます。この詳細については、 JDGドキュメント を参照してください。

Infinispan documentation.

| SYNCまたはASYNCバックアップで述べた他のすべてのKeycloakキャッシュについても、通常はこれらの手順を実行する必要があります。 |

自動的作業 - バックアップに失敗した後、通常は site2 が自動的にオフラインになります。これは、Infinispanサーバーのセットアップで設定されたキャッシュ設定内の take-offline 要素の設定によって行われます。

<take-offline min-wait="60000" after-failures="3" />この例では、少なくとも3回連続して失敗したバックアップがあり、60秒以内にバックアップが成功しなかった場合、特定のシングルキャッシュに対してサイトが自動的にオフラインになることを示しています。

自動的にサイトをオフラインにすることは、特に、サイト間の切断されたネットワークが計画外である場合に便利です。欠点は、ネットワークの停止が検出されるまで何らかのバックアップが失敗し、アプリケーション側で障害が起きてる可能性があります。たとえば、一部のユーザーのログインに失敗したり、大きなログインタイムアウトが発生したりします。 特に、値が FAIL の failure-policy が使用されている場合です。

| サイトがオフラインであるかどうかの追跡は、キャッシュごとに個別に行われます。 |

一旦ネットワークが復旧し、 site1 と site2 がお互いに通信することができたら、サイトをオンラインにする必要があります。これは、サイトをオフラインにするのと同じように、JMXまたはCLIを使用して手動で行う必要があります。再度キャッシュをすべてチェックし、オンラインにする必要があります。

サイトをオンラインにしたら、通常は次のようにするのが良いです。

-

ステート・トランスファーを行います。

-

手動でキャッシュのクリアを行います。

ステート・トランスファー

ステート・トランスファーは、手動で行う必要があります。Infinispanサーバーはこれを自動的には行いません。たとえば、スプリット・ブレイン中は、誰がどのサイトを優先するかを管理者のみが決定することができます。したがって、ステート・トランスファーが両方のサイト間で双方向に、または site1 から site2 へのみ単方向で行われる必要がありますが、site2 から site1 への単方向は行われません。

双方向のステート・トランスファーによって、スプリット・ブレインの 後に site1 で作成されたエンティティーが site2 に確実に転送されます。これは site2 ではまだ発生していないので問題ありません。同じように、スプリット・ブレインの 後に site2 で作成されたエンティティーは site1 に転送されます。おそらく問題のある部分は、両方のサイトのスプリット・ブレインの 前に 存在し、両方のサイトのスプリット・ブレイン中に更新されたエンティティーです。これが発生すると、サイトの1つが 勝ち 、2番目のサイトがスプリット・ブレイン中に行った更新を上書きします。

残念ながら、これに対する広く一般的な解決方法はありません。スプリット・ブレインやネットワークの停止は状態に過ぎず、サイト間で100%の一貫性のあるデータで100%正確に処理することは通常不可能です。Keycloakの場合、これは特に重大な問題ではありません。最悪の場合、ユーザーがクライアントに再度ログインするか、loginFailuresの不正カウント数をブルートフォース保護のために追跡する必要があります。スプリット・ブレインに対処するためのヒントについては、Infinispan/JGroupsドキュメントを参照してください。

ステート・トランスファーは、JMXを介してInfinispanサーバー側でも行われます。操作名は pushState です。状態をモニタリングしたり、プッシュ状態をキャンセルしたりするその他の操作はほとんどありません。ステート・トランスファーの詳細については、 Infinispan docs を参照してください。

キャッシュのクリア

スプリット・ブレイン後は、Keycloakの管理コンソールで手動でキャッシュをクリアするのが安全です。これは、 site1 のデータベースで変更されたデータがあり、イベントのために無効にする必要のあるキャッシュが、スプリット・ブレイン中に site2 へ転送されなかった可能性があるためです。したがって、 site2 のKeycloakノードでは、キャッシュ内に古いデータがまだ残っている可能性があります。

キャッシュをクリアするには、 サーバー・キャッシュのクリア を参照してください。

ネットワークが復旧したら、いずれかのサイトの1つのKeycloakノードでキャッシュをクリアするだけで十分です。キャッシュの無効化イベントは、それぞれのサイトの他のKeycloakノードすべてに送られます。ただし、すべてのキャッシュ(レルム、ユーザー、鍵)に対して実行する必要があります。詳しくは、サーバー・キャッシュのクリアを参照してください。

Infinispanキャッシュ設定のチューニング

このセクションでは、JDGキャッシュを設定するためのヒントとオプションについて説明します。

デフォルトでは、Infinispanの clustered.xml ファイル内にあるInfinispanキャッシュ設定のバックアップの設定 failure-policy が FAIL に設定されています。必要に応じて WARN または IGNORE に変更できます。

FAIL と WARN の違いは、 FAIL が使用され、Infinispanサーバーが別のサイトにデータのバックアップを試みたときに、バックアップが失敗すると、その失敗が呼び出し側(Keycloakサーバー)に伝播されるという点です。2番目のサイトが一時的に到達不能になったり、同じエンティティーの更新を試みる同時トランザクションが発生した場合は、バックアップが失敗する可能性があります。この場合、Keycloakサーバーは複数回再試行します。ただし、その再試行が失敗した場合、より長いタイムアウト後、ユーザーにはエラーが表示されます。

WARN を使用すると、失敗したバックアップは、InfinispanサーバーからKeycloakサーバーに伝播されません。失敗したバックアップは無視され、ユーザーにはエラーが表示されません。バックアップのデフォルトのタイムアウトは10秒間であるため短いです。これは、 backup 要素の timeout 属性によって変更することができます。タイムアウトにおける再試行はありません。タイムアウト時は、InfinispanサーバーのログにWARNINGメッセージが表示されます。

潜在的な課題としては、いくつかのケースで、再試行( FAIL ポリシーの使用)が役に立つサイト間で短いネットワーク停止が発生する可能性があるため、 WARN (再試行なし)では、サイト間でデータの不整合が発生します。これは、両方のサイトで同時に同じエンティティーを更新しようとする際にも発生します。

これらの不整合はどれほど悪いことなのでしょうか。通常は、ユーザーが再認証する必要があることだけを意味します。

WARN ポリシーを使用すると、 actionTokens キャッシュにより提供され、その特定のキーを処理する、使い捨てのキャッシュが実際に1回使用されますが、同じキーが2回"正常に"書き込まれる可能性があります。しかし、たとえば、OAuth2 仕様では、コードは使い捨てでなければならないと言及されています。 WARN ポリシーでは、これは厳密には保証されておらず、両方のサイトで同時に書き込まれる試みがあった場合、同じコードが2回書き込まれる可能性があります。

より長いネットワーク停止またはスプリット・ブレインが起きた場合、 FAIL と WARN を使用すると、サイトをオフラインおよびオンラインにするで説明したとおり、少し時間を置いて失敗した後、他のサイトはオフラインになります。デフォルトの1分のタイムアウトでは、関連するキャッシュがすべてオフラインになるまで、通常は1~3分かかります。その後、エンドユーザーの観点から、動作はすべて問題なく進みます。サイトをオフラインおよびオンラインにするで説明したとおり、オンラインに戻ったときに手動でサイトを復元する必要があります。

要約すると、サイト間で頻繁により長い停止が発生する可能性があり、データの不整合と100%正確ではない使い捨てのキャッシュについては許容されますが、エラーや長いタイムアウトがエンドユーザーに表示されないようにする場合には、 WARN に切り替えます。

WARN と IGNORE の違いは、 IGNORE では警告がInfinispanログに書き込まれていないことです。詳細については、Infinispanのドキュメントを参照してください。

デフォルト設定では、NON_DURABLE_XAモードでトランザクションを取得タイムアウト0で使用しています。これは、同じキーに対して進行中の別のトランザクションがある場合、トランザクションはすぐに失敗することを意味します。

デフォルトの10秒ではなく0に切り替えるのは、デッドロックの可能性を避けるためです。Keycloakでは、同じエンティティー(通常はセッション・エンティティーまたはloginFailure)が両方のサイトから同時に更新されることがあります。これにより、状況によってはデッドロックが発生し、トランザクションが10秒間ブロックされる可能性があります。 詳細については、 このJIRAレポート を参照してください。

タイムアウト0の場合、トランザクションは直ちに失敗し、値 FAIL のバックアップ failure-policy が設定されていれば、Keycloakから再試行されます。2番目の同時トランザクションが終了するまで、通常は再試行が成功し、エンティティーは両方の同時トランザクションから更新を適用します。

この設定での同時トランザクションは、非常に良い一貫性と結果が得られるため、そのまま使用することをお勧めします。

唯一の(機能しない)問題は、Infinispanサーバーログの例外です。これは、ロックがすぐに利用できなくなるたびに発生します。

SYNCまたはASYNCバックアップ

backup 要素の重要な部分は strategy 属性です。 SYNC と ASYNC のどちらが必要かを決める必要があります。クロスサイト・レプリケーションを認識できる7つのキャッシュがあり、これらは、クロスサイトに対する次の3つの異なるモードで設定できます。

-

SYNCバックアップ

-

ASYNCバックアップ

-

バックアップを全くしない

SYNC バックアップが使用された場合、バックアップが同期され、バックアップが2番目のサイトで処理されると、呼び出し側(Keycloakサーバー)で操作が完了したとみなされます。これは ASYNC よりもパフォーマンスが劣りますが、一方で、 site2 のユーザー・セッションなど特定のエンティティーの後続の読み込みによって、 site1 からの更新が確実に確認されます。また、データの一貫性が必要な場合は、これは必須になります。 ASYNC の場合と同様に、他のサイトへのバックアップが失敗した場合は、呼び出し側には全く通知されません。

キャッシュによっては、バックアップをまったく取らず、Infinispanサーバーへのデータ書き込みを完全にスキップすることも可能です。これを設定するために、 Keycloak側( KEYCLOAK_HOME/standalone/configuration/standalone-ha.xml ファイル)の特定のキャッシュに remote-store 要素を使用しないでください。また、特定の replicated-cache 要素もInfinispanサーバー側では必要ありません。

デフォルトでは、7つのキャッシュすべてが最も安全なオプションである SYNC バックアップで設定されています。考慮すべき点は次のとおりです。

-

アクティブ/パッシブモード(すべてのKeycloakサーバーが単一のサイト

site1にあり、site2にあるInfinispanサーバーが純粋にバックアップとしてのみ使用されます。詳しくは モードを参照してください)を使用している場合、パフォーマンスを低下させないよう、すべてのキャッシュにASYNC方式を使用するのが通常は望ましいです。 -

workキャッシュは、主に、キャッシュ無効化イベントなどのいくつかのメッセージを他のサイトに送信するために使用されます。また、userStorageの同期化などの特別なイベントが単一のサイトでのみ発生するようにするためにも使用されます。これをSYNCに設定することを推奨します。 -

actionTokensキャッシュは、使い捨てのキャッシュとして使用され、トークンまたはチケットが1回だけ使用されたということを追跡します。たとえば、アクショントークンまたはOAuth2のコードです。これをASYNCに設定して、パフォーマンスをわずかに向上させることは可能ですが、特定のチケットが実際に1回だけ使用され使い捨てになるかは保証されていません。たとえば、両方のサイトで同じチケットの同時リクエストがある場合、ASYNC方式によって両方のリクエストが成功する可能性があります。そのため、ここでの設定は、セキュリティー(SYNC方式)を優先するか、パフォーマンス(ASYNC方式)を優先するかによります。 -

loginFailuresキャッシュは、3つのモードのいずれかで使用できます。バックアップがまったくない場合、ユーザーのログイン失敗のカウントがサイトごとに個別にカウントされることを意味します(詳しくはInfinispanキャッシュを参照してください)。これにはいくつかのセキュリティー上の意味がありますが、パフォーマンス上の利点があります。また、サービス拒否(DoS)攻撃のリスクを軽減します。たとえば、攻撃者が両方のサイトでユーザーのユーザー名とパスワードを使用して1000件の同時リクエストをシミュレートすると、サイト間で多くのメッセージが渡され、ネットワークの混雑が発生する可能性があります。ASYNC方式は、攻撃者のリクエストが他のサイトへのバックアップを待つことによってブロックされず、潜在的にさらに混雑したネットワーク・トラフィックを招くため、状況は悪化する可能性があります。ログイン失敗のカウントもASYNC方式では正確ではありません。

データセンター間のネットワークが遅く、DoSの確率が高い環境では、 loginFailures キャッシュをまったくバックアップしないことが推奨されます。

-

sessionsとclientSessionsキャッシュをSYNCで保持しておくことをお勧めします。ユーザーのリクエストとバックチャネル・リクエスト(リクエスト処理で説明したクライアント・アプリケーションからKeycloakへのリクエスト)が常に同じサイトで処理されることが確かな場合にのみ、それらをASYNCへ切り替えることが可能になります。たとえば、次のような場合はこれが当てはまります。-

モードで説明した通り、アクティブ/パッシブモードを使用しています。

-

クライアント・アプリケーションはすべてKeycloak JavaScriptアダプターを使用しています。JavaScriptアダプターは、ブラウザー内でバックチャネル・リクエストを送信するため、それらはブラウザーのスティッキー・セッションに参加し、このユーザーの別のブラウザー・リクエストと同じクラスターノード(したがって同じサイト)で終了します。

-

ロードバランサーは、クライアントIPアドレス(ロケーション)に基づいてリクエストを処理でき、クライアント・アプリケーションは両方のサイトにデプロイされています。

たとえば、ロンドンとニューヨークの2つのサイトがあります。 アプリケーションがロンドンサイトとニューヨークサイトの両方に配備されている場合は、ロンドンユーザーからのすべてのユーザー・リクエストがロンドンサイトのアプリケーションとロンドンサイトのKeycloakサーバーにリダイレクトされるようにすることができます。 ロンドンサイトのクライアント・デプロイメントからのバックチャネル・リクエストは、ロンドンサイトのKeycloakサーバーでも終了します。 一方、米国のユーザーの場合、すべてのKeycloakリクエスト、アプリケーション・リクエスト、バックチャネル・リクエストはニューヨークサイトで処理されます。

-

-

offlineSessionsとofflineClientSessionsに対して、それは類似していますが、クライアント・アプリケーションのいずれに対してもオフライン・トークンを使用する予定ががない場合、それらをバックアップする必要はまったくありません。

一般的に、懸念があり、パフォーマンスがブロッカーではない場合は、キャッシュを SYNC 方式に保持する方が安全です。

SYNC/ASYNCバックアップへの切り替えに関しては、 backup 要素の strategy 属性を編集してください。たとえば、次のようになります。

|

<backup site="site2" failure-policy="FAIL" strategy="ASYNC" enabled="true">cache-configuration要素の mode 属性に注意してください。

トラブルシューティング

以下のヒントは、トラブルシューティングが必要な場合に役立ちます。

-

Infinispan 9.4.19でのクロスサイト・レプリケーションの設定を行い、最初にこの機能を有効にして、どのように動作するかを理解することをお勧めします。物事を理解するためにこの文書全体を読むことも賢明です。

-

Infinispanサーバーのセットアップで説明されているように、jconsoleクラスターのステータス(GMS)とInfinispanのJGroupsのステータス(RELAY)をチェックインします。状況が期待どおりに見えない場合、問題はInfinispanサーバーの設定にある可能性があります。

-

Keycloakサーバーの場合、サーバーの起動時に次のようなメッセージが表示されます。

18:09:30,156 INFO [org.keycloak.connections.infinispan.DefaultInfinispanConnectionProviderFactory] (ServerService Thread Pool -- 54) Node name: node11, Site name: site1Keycloakサーバーの起動時に、サイト名とノード名が想定どおりに表示されていることを確認してください。

-

同じデータセンターのKeycloakサーバーだけが互いにクラスター化されていることを含め、Keycloakサーバーが期待どおりにクラスター内にあることを確認してください。これは、GMSビューを介してJConsoleでチェックすることもできます。詳細については、クラスターのトラブルシューティングを参照してください。

-

Keycloakサーバーの起動時に次のような例外が発生した場合、

17:33:58,605 ERROR [org.infinispan.client.hotrod.impl.operations.RetryOnFailureOperation] (ServerService Thread Pool -- 59) ISPN004007: Exception encountered. Retry 10 out of 10: org.infinispan.client.hotrod.exceptions.TransportException:: Could not fetch transport ... Caused by: org.infinispan.client.hotrod.exceptions.TransportException:: Could not connect to server: 127.0.0.1:12232 at org.infinispan.client.hotrod.impl.transport.tcp.TcpTransport.<init>(TcpTransport.java:82)これは通常、Keycloakサーバーが自身のデータセンター内のInfinispanサーバーにアクセスできないことを意味します。ファイアウォールが期待どおりに設定され、Infinispanサーバーが接続可能であることを確認してください。

-

Keycloakサーバーの起動時に次のような例外が発生した場合、

16:44:18,321 WARN [org.infinispan.client.hotrod.impl.protocol.Codec21] (ServerService Thread Pool -- 57) ISPN004005: Error received from the server: javax.transaction.RollbackException: ARJUNA016053: Could not commit transaction. ...サイトの該当するInfinispanサーバーのログをチェックし、他のサイトへのバックアップに失敗したかどうかを確認します。バックアップ・サイトが利用できない場合は、Infinispanサーバーがオフラインサイトにバックアップしようとしないようにオフラインに切り替えて、Keycloakサーバー側で正常に操作が成功するようにすることをお勧めします。詳細については、 クロスサイト・デプロイメントの管理 を参照してください。

-

JMXを介して利用可能なInfinispanの統計を確認してください。たとえば、ログインして、新しいセッションがInfinispanサーバーの両方に正常に書き込まれたかどうかを確認し、そこの

sessionsキャッシュで利用可能かどうかを確認します。これは、MBeanjboss.datagrid-infinispan:type=Cache,name="sessions(repl_sync)",manager="clustered",component=StatisticsとnumberOfEntries属性のsessionsキャッシュ内の要素の数をチェックすることによって間接的に行うことができます。ログイン後、両方のサイトのそれぞれのInfinispanサーバーにnumberOfEntriesの1つ以上のエントリーが存在するはずです。 -

Keycloakサーバーのセットアップの説明に従って、DEBUGロギングを有効にします。たとえば、ログインして2番目のサイトで新しいセッションが利用できないと思われる場合は、Keycloakサーバーログをチェックし、Keycloakサーバーのセットアップで説明したようにリスナーがトリガーされていることを確認してください。keycloak-userメーリングリストに質問したい場合は、電子メール内の両方のデータセンターのKeycloakサーバーからログファイルを送信すると便利です。ログスニペットをメールに追加するか、ログをどこかに置いて電子メールで参照してください。

-

site1のKeycloakサーバーでuserなどのエンティティーを更新しても、site2のKeycloakサーバーで更新したエンティティーが表示されない場合は、同期したデータベース自体のレプリケーションか、Keycloakキャッシュが適切に無効化されなかったかのどちらかに問題があります。問題がデータベースのレプリケーション・レベルにある場合は、ここで説明するように一時的にKeycloakキャッシュを無効化してください。また、データベースに手動で接続し、データが期待どおりに更新されるかどうかを確認するのに役立ちます。これはすべてのデータベースに固有のものなので、データベースのドキュメントを参照する必要があります。 -

場合によっては、Infinispanサーバーログに次のようなロックに関する例外が表示されることがあります。

(HotRodServerHandler-6-35) ISPN000136: Error executing command ReplaceCommand, writing keys [[B0x033E243034396234..[39]]: org.infinispan.util.concurrent.TimeoutException: ISPN000299: Unable to acquire lock after 0 milliseconds for key [B0x033E243034396234..[39] and requestor GlobalTx:server1:4353. Lock is held by GlobalTx:server1:4352これらの例外は必ずしも問題ではありません。両方のデータセンターで同じエンティティーの同時編集がトリガーされると、いつでも発生する可能性があります。これは、デプロイメントの多くの場合に当てはまります。たいてい、Keycloakサーバーは、失敗した操作について通知を受けて再試行するため、ユーザーの観点からは通常問題はありません。

-

Keycloakサーバーの起動時に次のような例外が発生した場合。

16:44:18,321 WARN [org.infinispan.client.hotrod.impl.protocol.Codec21] (ServerService Thread Pool -- 55) ISPN004005: Error received from the server: java.lang.SecurityException: ISPN000287: Unauthorized access: subject 'Subject with principal(s): []' lacks 'READ' permission ...これらのログエントリーはKeycloakの結果で、Infinispanで認証が必要かどうかを自動的に検出し、認証が必要であることを意味します。この時点で、サーバーが正常に起動され、これらを無視しても問題ないか、またはサーバーの起動に失敗していることに気づきます。サーバーの起動に失敗した場合は、Infinispanが Infinispanサーバーのセットアップ で説明されているように認証のために正しく設定されていることを確認してください。このログエントリーが含まれないように、

spi=connectionsInfinispan/provider=defaultの設定でremoteStoreSecurityEnabledプロパティーをtrueに設定して認証を強制できます。<subsystem xmlns="urn:jboss:domain:keycloak-server:1.1"> ... <spi name="connectionsInfinispan"> ... <provider name="default" enabled="true"> <properties> ... <property name="remoteStoreSecurityEnabled" value="true"/> </properties> </provider> </spi> -

Keycloakでアプリケーションに認証しようとすると、ブラウザーの無限のリダイレクトで認証に失敗し、Keycloakサーバーログに次のようなエラーが表示されます。

2017-11-27 14:50:31,587 WARN [org.keycloak.events] (default task-17) type=LOGIN_ERROR, realmId=master, clientId=null, userId=null, ipAddress=aa.bb.cc.dd, error=expired_code, restart_after_timeout=trueおそらく、スティッキー・セッションをサポートするようにロードバランサーを設定する必要があることを意味します。Keycloakサーバー起動中に使用される指定されたルート名(プロパティー

jboss.node.name)に、 ロードバランサー・サーバーが現在のサーバーを識別するために使用する正しい名前が含まれていることを確認してください。 -

Infinispanの

workキャッシュが無期限に増加した場合、 このInfinispanの問題 が発生している可能性があります(キャッシュが正しく期限切れになっていないことに起因する問題)。その場合、キャッシュ宣言を次のような空の<expiration />タグで更新してください。<replicated-cache name="work" configuration="sessions-cfg"> <expiration /> </replicated-cache> -

Infinispanサーバーのログに次のような警告が表示された場合は、

18:06:19,687 WARN [org.infinispan.server.hotrod.Decoder2x] (HotRod-ServerWorker-7-12) ISPN006011: Operation 'PUT_IF_ABSENT' forced to return previous value should be used on transactional caches, otherwise data inconsistency issues could arise under failure situations 18:06:19,700 WARN [org.infinispan.server.hotrod.Decoder2x] (HotRod-ServerWorker-7-10) ISPN006010: Conditional operation 'REPLACE_IF_UNMODIFIED' should be used with transactional caches, otherwise data inconsistency issues could arise under failure situationsそれらを無視することができます。この警告を回避するために、Infinispanサーバー側のキャッシュをトランザクション・キャッシュに変更することができますが、バグ https://issues.redhat.com/browse/ISPN-9323 によって引き起こされるいくつかの他の問題が発生する可能性があるため、これはお勧めしません。したがって、今のところこの警告は無視する必要があります。

-

Infinispanサーバーのログに次のようなエラーが表示された場合は、

12:08:32,921 ERROR [org.infinispan.server.hotrod.CacheDecodeContext] (HotRod-ServerWorker-7-11) ISPN005003: Exception reported: org.infinispan.server.hotrod.InvalidMagicIdException: Error reading magic byte or message id: 7 at org.infinispan.server.hotrod.HotRodDecoder.readHeader(HotRodDecoder.java:184) at org.infinispan.server.hotrod.HotRodDecoder.decodeHeader(HotRodDecoder.java:133) at org.infinispan.server.hotrod.HotRodDecoder.decode(HotRodDecoder.java:92) at io.netty.handler.codec.ByteToMessageDecoder.callDecode(ByteToMessageDecoder.java:411) at io.netty.handler.codec.ByteToMessageDecoder.channelRead(ByteToMessageDecoder.java:248)また、Keycloakログに類似のエラーが表示された場合は、互換性のないバージョンのHot Rodプロトコルが使用されていることを示しています。これは、Keycloakを古いバージョンのInfinispanサーバーで使用しようとした場合に発生する可能性があります。Keycloak設定ファイルの

remote-store要素に、追加のプロパティーとしてprotocolVersionプロパティーを追加すると役に立ちます。たとえば次のように設定します。<property name="protocolVersion">2.6</property>

サブシステム設定の管理

Keycloakの低レベルな設定は、配布物に含まれている standalone.xml 、 standalone-ha.xml 、または domain.xml ファイルを編集して行います。このファイルの場所は動作モードによって異なります。

ここで設定可能な設定は無限にありますが、このセクションでは keycloak-server サブシステムの設定について説明します。どの設定ファイルを使用していても、 keycloak-server サブシステムの設定は同じです。

keycloak-serverサブシステムは通常、以下のようにファイルの末尾で宣言されています。

<subsystem xmlns="urn:jboss:domain:keycloak-server:1.1">

<web-context>auth</web-context>

...

</subsystem>このサブシステム内での変更はサーバーが再起動されるまで有効になりませんので、注意してください。

SPIプロバイダーの設定

各設定の詳細については、その設定と関連する別の箇所で説明します。ただし、SPIプロバイダー設定の宣言に使用される形式について学ぶことをお勧めします。

Keycloakは、柔軟性に優れた、高度なモジュールシステムです。50以上のサービス・プロバイダー・インターフェイス(いわゆるSPI)があり、各SPIの実装を交換することができます。SPIの実装は provider によって行われます。

SPI宣言のすべての要素は任意で選択できるものですが、完全なSPI宣言は以下のようになります。

<spi name="myspi">

<default-provider>myprovider</default-provider>

<provider name="myprovider" enabled="true">

<properties>

<property name="foo" value="bar"/>

</properties>

</provider>

<provider name="mysecondprovider" enabled="true">

<properties>

<property name="foo" value="foo"/>

</properties>

</provider>

</spi>ここでは、 myspi というSPIに2つのプロバイダーが定義されています。 default-provider は myprovider と表示されています。しかし、この設定をどのように処理するかはSPIが決定します。SPIによって複数のプロバイダーを許可するものもあれば、そうでないものもあります。そのため、 default-provider はSPIの選択の手助けになります。

また、各プロバイダーが独自の設定プロパティーを定義することについても注意してください。上記の両方のプロバイダーが foo というプロパティーを持っている点は単なる偶然です。

プロパティー値のタイプはそれぞれプロバイダーによって解釈されます。ただし、1つ例外があります。 eventsStore のSPIの jpa プロバイダーについて確認してみましょう。

<spi name="eventsStore">

<provider name="jpa" enabled="true">

<properties>

<property name="exclude-events" value="["EVENT1",

"EVENT2"]"/>

</properties>

</provider>

</spi>この値は角括弧で始まり、角括弧で終わることが分かります。これは、値がリストとしてプロバイダーに渡されることを意味します。このサンプルでは、2つの要素値 EVENT1 と EVENT2 のリストはシステムからプロバイダーに渡されます。リストに値を追加するには、各リスト要素をカンマで区切ります。残念ながら、各リスト要素を囲む引用符を " にエスケープする必要があります。

カスタム・プロバイダーとプロバイダーの設定の詳細については、Server Developer Guide の手順に従ってください。

WildFly CLIの起動

設定変更は、手作業で編集するだけでなく、 jboss-cli ツールでコマンドを発行して行うこともできます。CLIを使用すると、サーバーをローカルでもリモートでも設定することができます。スクリプティングと組み合わせると特に便利です。

WildFlyCLIを起動するには、 jboss-cli を実行する必要があります。

$ .../bin/jboss-cli.sh> ...\bin\jboss-cli.batこれを実行すると、以下のようにプロンプトが表示されます。

[disconnected /]実行中のサーバーでコマンドを実行する場合、まず connect コマンドを実行します。

[disconnected /] connect

connect

[standalone@localhost:9990 /]ここでユーザー名もパスワードも入力していないと思うかもしれませんが、 jboss-cli を実行中のスタンドアローン・サーバーまたはドメイン・コントローラーと同じマシンで実行し、アカウントに適切なファイル・アクセス権限がある場合は、管理者のユーザー名とパスワードを設定または入力する必要はありません。この設定では心配で、よりセキュアにしたい場合の詳細は、WildFly 23 Documentationを参照してください。

CLI組み込みモード

サーバーがアクティブではない間にスタンドアローン・サーバーと同じマシン上にコマンドが発行された場合は、サーバーをCLIに組み込み、受信要求を許可しない特殊モードに変更することができます。これを行うには、まず、変更したい設定ファイルで embed-server コマンドを実行します。

[disconnected /] embed-server --server-config=standalone.xml

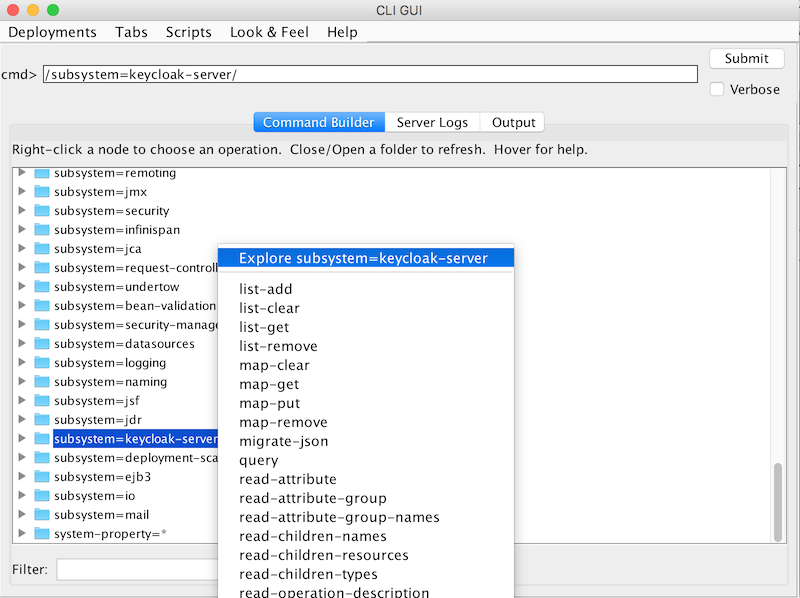

[standalone@embedded /]CLI GUIモードの使用

CLIはGUIモードでも実行できます。GUIモードでは、実行中のサーバーの管理モデル全体をグラフィカルに表示および編集できるSwingアプリケーションが起動します。GUIモードは、CLIコマンドの書式を設定したり、オプションを調べる際のヘルプとして特に便利です。GUIは、ローカルまたはリモートサーバーからサーバーログを取得することもできます。

-

GUIモードでのCLIの起動

$ .../bin/jboss-cli.sh --gui注意: リモートサーバーに接続するには、

--connectオプションも渡します。詳しくは、 --helpオプションを参照してください。 -

スクロールダウンして、

subsystem=keycloak-serverというノードを見つけます。 -

ノードを右クリックして、

Explore subsystem=keycloak-serverを選択します。新しいタブには、keycloak-serverサブシステムのみが表示されます。

keycloak-serverサブシステム

CLIスクリプティング

CLIには、さまざまなスクリプト機能があります。スクリプトはCLIコマンドを含む単なるテキストファイルです。テーマとテンプレートのキャッシュをオフにする簡単なスクリプトを見ていきましょう。

/subsystem=keycloak-server/theme=defaults/:write-attribute(name=cacheThemes,value=false)

/subsystem=keycloak-server/theme=defaults/:write-attribute(name=cacheTemplates,value=false)スクリプトを実行するには、CLI GUIの Scripts メニューに従うか、または以下のようにコマンドラインからスクリプトを実行します。

$ cd bin

$ ./jboss-cli.sh --file=adapter-install-offline.cliCLIレシピ

ここでは、設定タスクおよびそれらをCLIコマンドで実行する方法について説明します。代入すべきという意味で、またはkeycloak-serverサブシステムという意味でワイルドカード・パス ** を使用しています。その点は注意してください。

スタンドアローンの場合、これは単に以下の意味になります。

** = /subsystem=keycloak-server

ドメインモードの場合、これは以下のような意味になります。

** = /profile=auth-server-clustered/subsystem=keycloak-server

dblock SPIの設定

**/spi=dblock/:add(default-provider=jpa)

**/spi=dblock/provider=jpa/:add(properties={lockWaitTimeout => "900"},enabled=true)Profiles

Keycloakには、デフォルトでは有効とされていない機能があり、完全にはサポートされていないものがあります。さらに、デフォルトで有効とされている機能を無効にすることもできます。

有効および無効にできる機能は、以下のとおりです。

| 名前 | Description | デフォルトで有効 | サポートレベル |

|---|---|---|---|

account2 |

新しいアカウント管理コンソール |

Yes |

Supported |

account_api |

アカウント管理REST API |

Yes |

Supported |

admin_fine_grained_authz |

きめ細かい管理権限 |

No |

Preview |

ciba |

OpenID Connect Client Initiated Backchannel Authentication (CIBA) |

Yes |

Supported |

client_policies |

クライアント設定ポリシーの追加 |

Yes |

Supported |

par |

OAuth 2.0 Pushed Authorization Requests(PAR) |

Yes |

Supported |

declarative_user_profile |

宣言型スタイルによるユーザー・プロファイルの設定 |

No |

Preview |

docker |

Dockerレジストリーのプロトコル |

No |

Supported |

impersonation |

管理者がユーザーに成り代わる機能 |

Yes |

Supported |

openshift_integration |

OpenShiftを保護するための拡張 |

No |

Preview |

scripts |

JavaScriptを使用したカスタム認証の記述 |

No |

Preview |

token_exchange |

Token Exchangサービス |

No |

Preview |

upload_scripts |

スクリプトのアップロード |

No |

非推奨 |

web_authn |

W3C Web Authentication(WebAuthn) |

Yes |

Preview |

すべてのプレビュー機能を有効にするには、次のようにサーバーを起動します。

bin/standalone.sh|bat -Dkeycloak.profile=previewstandalone/configuration/profile.properties (またはドメインモード内の server-one 用の domain/servers/server-one/configuration/profile.properties )ファイルを作成することにより、これを永続的に設定することができます。以下をファイルに追加します。

profile=preview特定の機能を有効にするには、以下のようにサーバーを起動します。

bin/standalone.sh|bat -Dkeycloak.profile.feature.<feature name>=enabledサンプルとして、Dockerを有効にするには -Dkeycloak.profile.feature.docker=enabled を使用します。

profile.properties ファイルに以下を追加することにより、永続的に設定することができます。

feature.docker=enabled特定の機能を無効にするには、以下のようにサーバーを起動します。

bin/standalone.sh|bat -Dkeycloak.profile.feature.<feature name>=disabledサンプルとして、代理ログイン機能を無効にするには -Dkeycloak.profile.feature.impersonation=disabled を使用します。

profile.properties ファイルに以下を追加することにより、永続的に設定することができます。

feature.impersonation=disabledリレーショナル・データベースの設定

Keycloakには、H2というJavaベースのリレーショナル・データベースが組み込まれています。これは、Keycloakがデータを保存するために使用するデフォルトのデータベースで、単に認証サーバーをそのまま実行できるように組み込まれただけのものです。そのため、プロダクション用の外部データベースに置き換えることを強くお勧めします。H2データベースは並行性の高いシチュエーションではあまり実用的ではないので、クラスター内でも使用しないでください。この章では、Keycloakをより成熟度の高いデータベースに接続する方法を説明します。

Keycloakでは、リレーショナル・データを保存するために2つの階層化技術が使用されます。最下層の技術はJDBCです。JDBCは、RDBMSへの接続に使用されるJavaAPIです。データベース・ベンダーによって提供されるデータベース・タイプ毎に、さまざまなJDBCドライバーがあります。この章では、これらのベンダー固有のドライバーのいずれかを使用するようにKeycloakを設定する方法について説明します。

データを保存するための最上層の技術は、Hibernate JPAです。これは、Javaオブジェクトをリレーショナル・データにマップするORマッピングAPIの1つです。Keycloakのデプロイメントで、Hibernateの設定に触れる必要はほとんどありませんが、そのまれなケースに遭遇した場合どうなるかを説明します。

| データソースの設定については、 WildFly 23 Documentation の中のデータソース設定の章the datasource configuration chapterで詳しく説明しています。 |

データベース設定のチェックリスト

以下は、KeycloakにRDBMSを設定するために行う手順です。

-

データベース用のJDBCドライバーの検索とダウンロード

-

ドライバーのJARをモジュールにパッケージ化し、このモジュールをサーバーにインストール

-

サーバーの設定プロファイルでJDBCドライバーを宣言

-

データベースのJDBCドライバーを使用するようにデータソース設定を変更

-

データベースへの接続パラメーターを定義するようにデータソース設定を変更

この章では、すべてのサンプルにおいてPostgreSQLを使用します。他のデータベースも同じ手順でインストールできます。

JDBCドライバーのパッケージ化

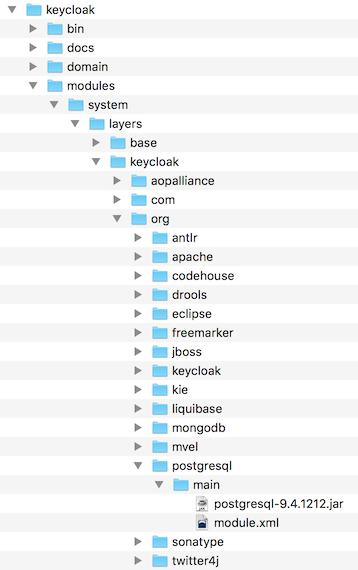

RDBMS用のJDBCドライバーのJARを検索してダウンロードします。このドライバーを使用する前に、モジュールにパッケージ化してサーバーにインストールする必要があります。モジュールによって、KeycloakのクラスパスにロードされるJAR、およびこれらのJARが他のモジュールに持つ依存関係が定義されます。

-

Keycloak配布ファイルの …/modules/ ディレクトリー内に、モジュールの定義を格納するディレクトリー構造を作成してください。

ディレクトリー構造の名前には、JDBCドライバーのJavaパッケージ名を使うのが一般的です。PostgreSQLの場合は、 org/postgresql/main というディレクトリーを作成します。

-

データベース・ドライバーのJARをこのディレクトリーにコピーし、その中に空の module.xml ファイルを作成します。

モジュール・ディレクトリー

-

module.xml ファイルを開き、以下のようなXMLを作成します。

モジュールXML<?xml version="1.0" encoding="UTF-8"?> <module xmlns="urn:jboss:module:1.3" name="org.postgresql"> <resources> <resource-root path="postgresql-VERSION.jar"/> </resources> <dependencies> <module name="javax.api"/> <module name="javax.transaction.api"/> </dependencies> </module>-

モジュール名は、モジュールのディレクトリー構造と一致していなければなりません。例えば、 org/postgresql は

org.postgresqlに対応します。 -

resource-root path属性は、ドライバーのJARファイル名を指定します。 -

残りの部分は、JDBCドライバーのJARが持っている通常の依存関係です。

-

JDBCドライバーの宣言とロード

JDBCをデプロイメント・プロファイルに宣言し、サーバー起動時にロードして利用できるようにします。

JDBCドライバーをパッケージ化しました。

-

デプロイメント・モードに応じて、これらのファイルのいずれかを編集し、JDBCドライバーを宣言します。

-

スタンドアローン・モードでは、 …/standalone/configuration/standalone.xml を編集します。

-

スタンドアローン・クラスタリング・モードの場合は、 …/standalone/configuration/standalone-ha.xml を編集してください。

-

ドメインモードの場合は、 …/domain/configuration/domain.xml を編集します。

ドメインモードでは、使用しているプロファイル(

auth-server-standaloneまたはauth-server-clusteredのいずれか)を編集することを確認してください。

-

-

プロファイル内で、

datasourcesサブシステム内のdriversXMLブロックを検索します。H2 JDBCドライバーの定義済みのドライバーが宣言されているはずです。ここでは、外部データベースのJDBCドライバーを宣言します。

JDBCドライバー<subsystem xmlns="urn:jboss:domain:datasources:6.0"> <datasources> ... <drivers> <driver name="h2" module="com.h2database.h2"> <xa-datasource-class>org.h2.jdbcx.JdbcDataSource</xa-datasource-class> </driver> </drivers> </datasources> </subsystem> -

driversのXMLブロック内で、追加のJDBCドライバーを宣言します。-

このドライバーに任意の

nameを付けます。 -

module属性を指定します。この属性は、ドライバーJAR用に以前作成したmoduleパッケージを指します。 -

ドライバーのJavaクラスを指定します。

ここでは、本章の前半で定義したモジュールのサンプルに含まれるPostgreSQLドライバーをインストールする例を紹介します。

JDBCドライバーの宣言<subsystem xmlns="urn:jboss:domain:datasources:6.0"> <datasources> ... <drivers> <driver name="postgresql" module="org.postgresql"> <xa-datasource-class>org.postgresql.xa.PGXADataSource</xa-datasource-class> </driver> <driver name="h2" module="com.h2database.h2"> <xa-datasource-class>org.h2.jdbcx.JdbcDataSource</xa-datasource-class> </driver> </drivers> </datasources> </subsystem>

-

Keycloakデータソースの変更

Keycloakが新しい外部データベースに接続するために使用する既存のデータソース設定を変更します。これは、JDBCドライバーを登録したのと同じ設定ファイルとXMLブロック内で行います。サンプルとして、新しいデータベースへの接続を設定すると以下のとおりになります。

<subsystem xmlns="urn:jboss:domain:datasources:6.0">

<datasources>

...

<datasource jndi-name="java:jboss/datasources/KeycloakDS" pool-name="KeycloakDS" enabled="true" use-java-context="true">

<connection-url>jdbc:postgresql://localhost/keycloak</connection-url>

<driver>postgresql</driver>

<pool>

<max-pool-size>20</max-pool-size>

</pool>

<security>

<user-name>William</user-name>

<password>password</password>

</security>

</datasource>

...

</datasources>

</subsystem>-

JDBCドライバーはすでに宣言しています。

-

KeycloakDSのdatasource定義を検索します。まず

connection-urlを変更する必要があります。この接続URL値の形式は、ベンダーのJDBC実装のドキュメントで指定されています。 -

次に、使用する

driverを定義します。これは、この章の前のセクションで宣言したJDBCドライバーの論理名になります。

トランザクションを実行するたびにデータベースへの新しい接続を開くのは処理コストがかかります。これを補うために、データソース実装は開いた接続のプールを維持します。

max-pool-sizeによって、プールする接続の最大数が指定されます。システムの負荷に応じて、この値を変更することができます。 -

データベースへの接続に必要なデータベースのユーザー名とパスワードを定義します。このステップは少なくともPostgreSQLでは必要です。この例では、これらのクレデンシャルが平文で表示されていることが気になるかもしれません。これらのクレデンシャルを難読化する方法がありますが、その方法はこのガイドの範囲外です。

| データソース機能について、詳しくは WildFly 23 Documentation 内のthe datasource configuration chapterを参照してください。 |

データベース設定

配布物内の standalone.xml 、 standalone-ha.xml 、 domain.xml のいずれかの中にこのコンポーネント用の設定があります。このファイルの場所は動作モードによって異なります。

<subsystem xmlns="urn:jboss:domain:keycloak-server:1.1">

...

<spi name="connectionsJpa">

<provider name="default" enabled="true">

<properties>

<property name="dataSource" value="java:jboss/datasources/KeycloakDS"/>

<property name="initializeEmpty" value="false"/>

<property name="migrationStrategy" value="manual"/>

<property name="migrationExport" value="${jboss.home.dir}/keycloak-database-update.sql"/>

</properties>

</provider>

</spi>

...

</subsystem>設定可能なオプションは、以下のとおりです。

- dataSource

-

データソースのJNDI名

- jta

-

データソースがJTA対応かどうか指定するbooleanプロパティー

- driverDialect

-

データベース・ダイアレクトの値。ほとんどの場合、ダイアレクトはHibernateによって自動検出されるため、このプロパティーを指定する必要はありません。

- initializeEmpty

-

空の場合はデータベースを初期化します。falseに設定する場合、データベースを手動で初期化する必要があります。データベースを手動で初期化するには、migrationStrategyを

manualに設定し、データベース初期化用のSQLコマンドが書かれたファイルを作成します。デフォルトはtrueになっています。 - migrationStrategy

-

データベースの移行に使用する戦略。有効な値は

update、manual、validateです。updateは、自動的にデータベース・スキーマを移行します。manualは、データベースに対して手動実行可能な、必要な変更のSQLコマンドが書かれたファイルをエクスポートします。validateは、データベースが最新であるかどうかを単にチェックするものです。 - migrationExport

-

手動によるデータベース初期化または移行用ファイルを書き込む場所のパス。

- showSql

-

Hibernateがコンソール内にすべてのSQLコマンドを表示するかどうかを指定します(デフォルトはfalse)。これは非常に冗長な出力となります。

- formatSql

-

HibernateがSQLコマンドをフォーマットするかどうかを指定します(デフォルトはtrue)。

- globalStatsInterval

-

実行されたDBクエリーなどに関する、Hibernateのグローバル統計情報をログに出力します。統計情報は、秒単位で指定された間隔でサーバーログに常にレポートされ、各レポート後にクリアされます。

- schema

-

使用するデータベース・スキーマを指定します。

| これらの設定スイッチなどについては、WildFly 23 Development Guideで説明します。 |

データベースのユニコードに関する考慮事項

Keycloakのデータベース・スキーマは、以下の特別なフィールドにだけユニコード文字列の使用を許可します。

-

レルム:表示名、HTML表示名、ローカライズテキスト(キーと値)

-

フェデレーション・プロバイダー:表示名

-

ユーザー:ユーザー名、氏名、属性名、値

-

グループ:名前、属性名、値

-

ロール:名前

-

オブジェクトの説明

上記以外の場合は、8ビットのデータベース・エンコーディングに含まれる文字に制限されます。ただし、データベース・システムによっては、ユニコード文字のUTF-8エンコーディングを有効にし、すべてのテキストフィールド内で完全なユニコード文字セットを使用することができます。これは8ビットエンコーディングの場合よりも文字列の最大長を短くすることによって相殺されます。

データベースによっては、ユニコード文字を処理できるようにデータベースとJDBCドライバーの両方、またはいずれかに特別な設定をする必要があります。以下のデータベースの設定を確認してください。データベースがここにリストされている場合、データベースとJDBCドライバーの両方のレベルでUTF-8エンコーディングが適切に処理されていれば、正常に動きます。この点には注意してください。

技術的には、すべてのフィールド内のユニコード・サポートの重要な基準は、データベースによって VARCHAR フィールドと CHAR フィールドにユニコード文字セットが設定できるかどうかになります。設定できる場合は、通常はフィールド長を犠牲にすることで、ユニコードは妥当となります。 NVARCHAR フィールドと NCHAR フィールド内のユニコードしかサポートされていない場合は、Keycloakスキーマは VARCHAR フィールドと CHAR フィールドを広範囲にわたって使用するため、すべてのテキストフィールドのユニコード・サポートはほとんどありません。

Oracleデータベース

VARCHAR フィールドと CHAR フィールド内でユニコード・サポートを使用してデータベースを作成した場合は、ユニコード文字は適切に処理されます(例: AL32UTF8 文字セットがデータベース文字セットとして使用された場合)。JDBCドライバーに特別な設定は必要ありません。

データベース文字セットがユニコードではない場合、ユニコード文字を特別なフィールド内で使用するために、JDBCドライバーを設定して接続プロパティー oracle.jdbc.defaultNChar を true に設定する必要があります。厳密には必須ではないのですが、 oracle.jdbc.convertNcharLiterals 接続プロパティーも true にしておいた方が賢明です。これらのプロパティーは、システム・プロパティーまたは接続プロパティーとして設定することができます。しかし oracle.jdbc.defaultNChar の設定はパフォーマンスに悪影響を与える可能性がありますので、この点は注意してください。詳しくは、Oracle JDBCドライバーの設定ドキュメントを参照してください。

MySQLデータベース

CREATE DATABASE コマンドで、 VARCHAR と CHAR のフィールド内のユニコード・サポートを使用してデータベースが作成される場合は、ユニコード文字は適切に処理されます(例:MySQL 5.5でデフォルトのデータベース文字セットとして utf8 文字セットを使用する場合。 utf8 文字セットに求められるさまざまなストレージ要件により、 utf8mb4 文字セットは動作しませんので注意してください [1] )。この場合、バイト数ではなく文字数に合わせて列が作成されるため、通常のフィールドには長さ制限は適用されないことに注意が必要です。データベースのデフォルト文字セットでユニコードの保存が許可されていない場合、特別なフィールドでのみユニコード値の保存が許可されることになります。

JDBCドライバー設定については、JDBC接続設定に接続プロパティー characterEncoding=UTF-8 を追加する必要があります。

PostgreSQLデータベース

データベース文字セットが UTF8 である場合、ユニコードはサポートされます。この場合、ユニコード文字はどのフィールドでも使用することができますが、通常フィールドではフィールド長は短縮されません。JDBCドライバーの特別な設定は必要ありません。

PostgreSQL Databaseの文字セットは作成時に決定されます。PostgreSQLクラスターのデフォルトの文字セットは以下のSQLコマンドで特定できます。

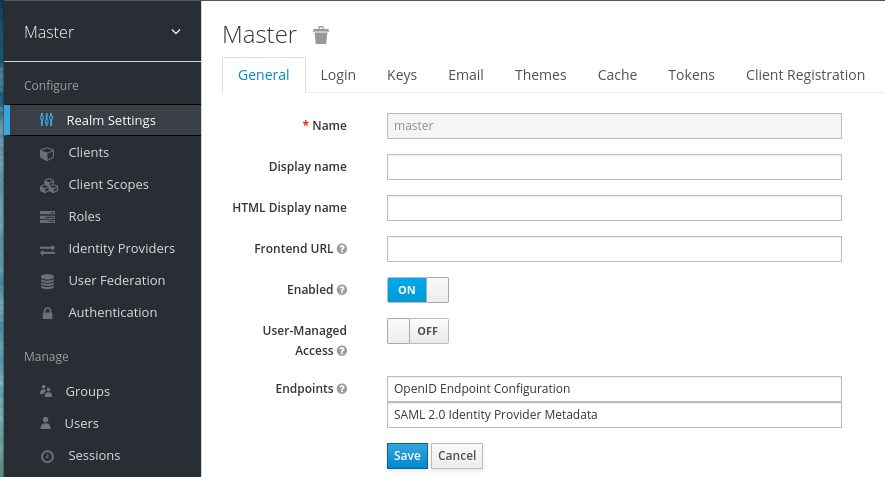

show server_encoding;デフォルトの文字セットがUTF-8でない場合は、次のように文字セットとしてUTF-8を使用してデータベースを作成することができます。